Abstract

Introduzione

Imparare a prevedere le ricompense è un notevole adattamento evolutivo che supporta un comportamento flessibile in ambienti complessi e instabili. Quando le circostanze cambiano, la conoscenza acquisita in precedenza può non essere più informativa e il comportamento deve essere adattato per beneficiare di nuove opportunità. Spesso, le alterazioni delle condizioni ambientali non sono segnalate da spunti esterni e possono essere dedotte solo da deviazioni dai risultati previsti, cioè da segnali di sorpresa.

Quando si prendono decisioni, gli esseri umani tipicamente cercano di massimizzare i benefici (cioè la quantità di ricompensa) ricevuti per ogni risorsa investita (cioè, denaro, tempo, sforzo fisico o cognitivo). Noi, come molti altri animali, calcoliamo il valore economico che tiene conto dei premi e dei costi associati alle opzioni comportamentali disponibili e scegliamo l’alternativa che ci si aspetta porti a risultati del valore più alto sulla base di esperienze precedenti in condizioni simili(Padoa-Schioppa e Schoenbaum, 2015; Sugrue et al., 2005). Quando i risultati delle scelte violano costantemente le aspettative, è necessario un nuovo apprendimento per massimizzare l’acquisizione di ricompense. Tuttavia, non tutti i risultati inaspettati sono causati da cambiamenti significativi dell’ambiente. Anche quando le condizioni sono complessivamente stabili, i risultati di una singola esperienza possono essere ancora imprevedibili a causa di piccole fluttuazioni (cioè l’incertezza attesa) nei premi e nei costi. Tali fluttuazioni complicano l’apprendimento guidato dalla sorpresa, poiché gli animali hanno bisogno di distinguere tra i veri cambiamenti dell’ambiente e il feedback stocastico in condizioni altrimenti stabili, noto come il problema della rilevazione dei punti di cambiamento(Courville et al., 2006; Dayan et al., 2000; Gallistel et al., 2001; Pearce e Hall, 1980; Yu e Dayan, 2005).

Sia l’amigdala basolaterale (BLA) che la corteccia orbito-frontale (OFC) partecipano a un comportamento flessibile e reindirizzato. Le rappresentazioni dei risultati attesi possono essere decodificate da entrambe le regioni cerebrali durante il processo decisionale basato sul valore(Conen e Padoa-Schioppa, 2015; Haruno et al., 2014; Padoa-Schioppa, 2007, 2009; Salzman et al., 2007; van Duuren et al., 2009). Le lesioni dell’amigdala rendono gli animali incapaci di seguire in modo adattivo i cambiamenti nella disponibilità di ricompense o di beneficiare di periodi redditizi nell’ambiente(Murray e Izquierdo, 2007; Salinas et al., 1996; Salzman et al., 2007). Inoltre, una recente valutazione della letteratura accumulata sul BLA nel comportamento appetitivo suggerisce che questa regione integra sia il valore attuale della ricompensa che le informazioni storiche a lungo termine(Wassum e Izquierdo, 2015), e quindi può essere particolarmente adatta a guidare il comportamento quando le condizioni cambiano. È importante notare che le risposte a una singola unità di risposta nel BLA tracciano segnali a sorpresa(Roesch et al., 2010) che possono guidare l’apprendimento.

Allo stesso modo, un OFC funzionalmente intatto è necessario per le risposte adattive ai cambiamenti dei valori di risultato(Elliott et al., 2000; Izquierdo e Murray, 2010; Murray e Izquierdo, 2007). I danni prodotti dalle lesioni da OFC sono stati ampiamente attribuiti a una ridotta flessibilità cognitiva o a deficit di controllo inibitorio(Bari e Robbins, 2013; Dalley et al., 2004; Elliott e Deakin, 2005; Winstanley, 2007). Tuttavia, questo punto di vista è stato recentemente messo in discussione dalle osservazioni che le lesioni mediali selettive di OFC causano un potenziale passaggio tra le diverse alternative di opzioni, piuttosto che il mancato disimpegno dal comportamento precedentemente acquisito(Walton et al., 2010, 2011). Infatti, vi è una crescente evidenza che alcuni settori di OFC potrebbero non esercitare un controllo canonico inibitorio sull’azione, ma potrebbero invece contribuire alle rappresentazioni dei risultati previsti da specifici segnali nell’ambiente e aggiornare le aspettative in risposta a feedback sorprendenti(Izquierdo et al., 2017; Marquardt et al., 2017; Riceberg e Shapiro, 2012, 2017; Rudebeck e Murray, 2014; Stalnaker et al., 2015).

Nonostante gli importanti contributi sia del BLA che dell’OFC a diverse forme di apprendimento di valore adattivo, alcuni compiti di apprendimento progrediscono normalmente senza il reclutamento di queste regioni cerebrali. Ad esempio, l’OFC non è richiesto per l’acquisizione di semplici associazioni di stimoli e risultati, sia nel contesto pavloviano che in quello strumentale, o per lo sblocco guidato da differenze di valore quando i risultati sono certi e prevedibili. Tuttavia, l’OFC è necessario per comportamenti adattativi che richiedono l’integrazione di informazioni provenienti da fonti diverse, in particolare quando i risultati attuali devono essere confrontati con una storia in un contesto (o stato) diverso come nei paradigmi di svalutazione(Izquierdo et al., 2004; McDannald et al., 2011, 2005; Stalnaker et al., 2015). Allo stesso modo, come è stato dimostrato nei ratti, il BLA ha un ruolo importante nell’apprendimento precoce o nel processo decisionale in presenza di risultati ambigui(Hart e Izquierdo, 2017; Ostrander et al., 2011), e sembra giocare un ruolo limitato nel comportamento di scelta quando questi risultati sono conosciuti o rafforzati attraverso una formazione estesa. Queste osservazioni accennano a ruoli importanti per BLA e OFC nell’apprendimento in condizioni di incertezza. Tuttavia si sa poco sui contributi unici di queste regioni cerebrali al valore dell’apprendimento quando i risultati sono fluttuanti anche in condizioni di stabilità (cioè quando c’è incertezza attesa nei valori dei risultati). Inoltre, la dissociazione funzionale tra le diverse sottoregioni OFC (ad esempio ventromediale vs. laterale) è attualmente oggetto di dibattito(Dalton et al., 2016; Elliott et al., 2000; Morris et al., 2016).

Modelli computazionali sviluppati di recente basati sull’apprendimento di rinforzo (RL)(Diederen e Schultz, 2015; Khamassi et al., 2011; Preuschoff e Bossaerts, 2007) e i principi dell’inferenza bayesiana(Behrens et al., 2007; Nassar et al., 2010) sono adatti a testare i contributi unici di diverse regioni cerebrali per valutare l’apprendimento sotto l’incertezza. Questi modelli si basano sull’apprendimento in risposta alla sorpresa, o sulla deviazione tra i risultati attesi e quelli osservati (ad esempio, errori di previsione dei premi, RPE); il tasso di apprendimento, a sua volta, determina il grado in cui gli errori di previsione influenzano le stime dei valori. È importante notare che i principi di LR non tengono conto solo del comportamento animale, ma si riflettono anche nell’attività neuronale sottostante(Lee et al., 2012; Niv et al., 2015).

Nel presente lavoro, abbiamo sviluppato per la prima volta un nuovo paradigma comportamentale basato sul ritardo per indagare gli effetti dell’incertezza dei risultati attesi sull’apprendimento nei ratti. Abbiamo dimostrato che i ratti sono in grado di rilevare i veri cambiamenti nei valori di esito anche quando si verificano su uno sfondo di feedback stocastico. Tale complessità comportamentale nei roditori ci ha permesso di valutare i contributi causali del BLA e dell’OFC al valore dell’apprendimento sotto l’incertezza degli esiti attesi. In particolare, abbiamo esaminato i neuroadattamenti che si verificano in queste regioni cerebrali in risposta all’esperienza con diversi livelli di incertezza ambientale e abbiamo impiegato analisi comportamentali a grana fine in collaborazione con la modellazione computazionale delle prestazioni prova per prova degli animali affetti da OFC e BLA nel nostro compito che incorpora sia fluttuazioni prevedibili che spostamenti direzionali nei valori di esito.

Risultati

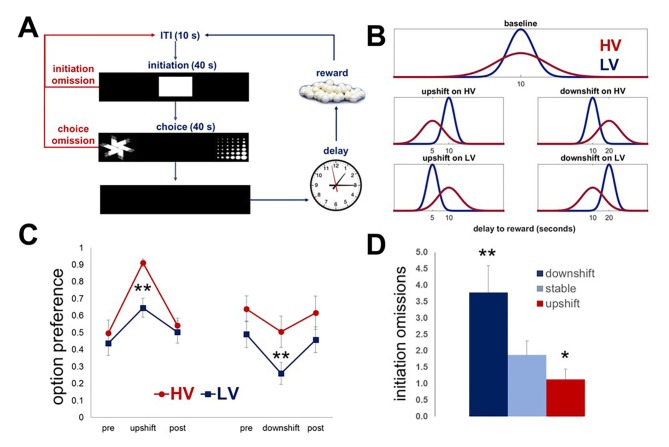

I ratti possono rilevare cambiamenti reali nei valori nonostante la variabilità dei risultati

Il nostro compito, basato sul ritardo, è stato progettato per valutare la capacità degli animali di rilevare i veri cambiamenti nei valori di risultato (cioè i cambiamenti in salita e in discesa) anche quando si verificano sullo sfondo di un feedback stocastico in condizioni di base (incertezza prevista). Per sondare gli effetti dell’incertezza dell’esito atteso sull’apprendimento nei roditori, abbiamo prima presentato un gruppo di ratti ingenui (n = 8) con due opzioni di scelta identiche nel tempo di attesa medio ma diverse nella varianza della distribuzione dell’esito. Ogni opzione di risposta è stata associata alla consegna di un pellet di zucchero dopo un intervallo di ritardo. I ritardi sono stati messi in comune da distribuzioni identiche nella media, ma diverse nella variabilità (bassa vs alta): LV vs HV; ~N(µ, σ): μ = 10 s, σ HV=4s σ LV=1 s). Dopo aver stabilito una performance stabile (definita come nessuna differenza statistica in nessuno dei parametri comportamentali in tre sessioni di test consecutive, incluse le omissioni di scelta e di avvio, le latenze medie di risposta e la preferenza per le opzioni), i ratti hanno sperimentato incrementi di valore (la media del ritardo è stata ridotta a 5 s con la varianza mantenuta costante) e decrementi (la media del ritardo è stata aumentata a 20 s) su ogni opzione in modo indipendente, seguiti dal ritorno alle condizioni di base(Figura 1A,B; Video 1, Video 2). Ogni turno e fase di base è durata cinque sessioni di test di 60 prove; pertanto, la durata totale del compito principale è stata di 43 giorni di test per ogni animale. I cambiamenti massimi nella scelta di ciascuna opzione in risposta ai turni sono stati analizzati con omnibus all’interno del soggetto ANOVA con il tipo di turno (HV, LV; upshift, downshift) e la fase di turno (pre-shift baseline, shift, post-shift baseline) come fattori interni al soggetto. Queste analisi hanno identificato un significativo tipo di shift x interazione di fase [F(6, 42)=16.412, p<0.0001]. Le analisi post-hoc non hanno rivelato differenze nelle preferenze alle condizioni di base tra le valutazioni [F(3,08, 21,57)=0,98, p=0,422; Greenhouse-Geisser corretto], suggerendo che i ratti sono stati in grado di dedurre i valori medi delle opzioni (tempi di attesa) e mantenere le preferenze di scelta stabili nonostante la variabilità dei risultati.10.7554/eLife.27483.003Figure 1.Task design e le prestazioni degli animali intatti.Il nostro compito è stato progettato per indagare gli effetti dell’incertezza dei risultati previsti sull’apprendimento dei valori.(A) Ogni prova è iniziata con la presentazione degli stimoli nello scomparto centrale del touchscreen. Ai ratti (n = 8) sono stati dati 40 s per iniziare una prova. Se 40 s sono passati senza una risposta, la prova è stata segnata come una “omissione di inizio”. Dopo una puntura al compartimento centrale, lo stimolo centrale è scomparso e due stimoli di scelta sono stati presentati contemporaneamente in ciascuno dei compartimenti laterali dello schermo tattile permettendo ad un animale una libera scelta tra due opzioni di ricompensa. Ad un animale sono stati dati 40 s per fare una scelta; la mancata selezione di un’opzione entro questo intervallo di tempo ha fatto sì che la prova venisse valutata come “omissione di scelta” e l’inizio di un ITI. Ogni opzione di risposta è stata associata alla consegna di un pellet di zucchero dopo un intervallo di tempo.(B) I ritardi associati a ciascuna opzione sono stati messi in comune da distribuzioni che sono identiche nel valore medio, ma diverse nella variabilità: LV (bassa variabilità, mostrata in blu) vs. HV (alta variabilità, mostrata in rosso); ~N(µ, σ): μ = 10 s, σ HV=4s, σ LV=1s. Dopo aver stabilito una prestazione stabile, i ratti hanno sperimentato incrementi di valore (µ = 5 s; σ mantenuto costante) e decrementi (μ = 20 s) su ogni opzione in modo indipendente, seguiti da un ritorno alle condizioni di base. Ogni turno e ritorno alla fase di base è durato per cinque sessioni di 60 prove.(C) Indipendentemente dal tipo di turno, gli animali hanno cambiato significativamente la loro preferenza in risposta a tutti i turni (tutti i valori di p<0,05). Tuttavia, sono state osservate differenze significative tra HV e LV negli adattamenti di scelta sia per i turni in salita che per quelli in discesa: una maggiore varianza della distribuzione dei risultati alla linea di base ha facilitato l’adattamento comportamentale in risposta ai turni in salita (differenza HV vs LV, p=0,004), ma ha reso gli animali non ottimali durante i turni in discesa (p=0,027); al contrario, la bassa incertezza prevista alla linea di base ha portato a una diminuzione della ricompensa durante i turni in salita. I dati sono mostrati come mezzi di gruppo per la preferenza delle opzioni durante le condizioni pre-baseline, turno e post-baseline, ± SEM. Gli asterischi indicano differenze statistiche tra le condizioni HV e LV.(D) Il numero di omissioni di avvio è stato significativamente aumentato durante il downshift (p=0,004) e diminuito durante gli upshifts (p=0,017) in valore, indipendentemente dai livelli di incertezza previsti, dimostrando gli effetti delle condizioni generali di ricompensa ambientale sulla motivazione ad impegnarsi nel compito. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0,05, **p<0,01. Le statistiche di sintesi e i dati individuali degli animali sono forniti nella figura 1-source data 1.DOI:http://dx.doi.org/10.7554/eLife.27483.00310.7554/eLife.27483.004Figure1-source data 1.Summary statistics and individual data for naïve animals performing the task.DOI:http://dx.doi.org/10.7554/eLife.27483.004Video1.Un animale che esegue il compito durante l’upshift sull’opzione HV.Durante un upshift di valore su ogni opzione, la media dei ritardi da premiare è stata ridotta a 5 s con varianza mantenuta uguale a quella delle condizioni di base.DOI:http://dx.doi.org/10.7554/eLife.27483.00510.7554/eLife.27483.005Video2.Un animale che esegue il compito durante il downshift sull’opzione HV.Durante un downshift di valore su ogni opzione, la media dei ritardi da premiare è stata aumentata a 20 s con varianza mantenuta costante.DOI:http://dx.doi.org/10.7554/eLife.27483.00610.7554/eLife.27483.006

Tutti gli animali hanno cambiato significativamente la loro preferenza in risposta a tutti i turni(Figura 1, tutti i valori di p<0,05). Abbiamo poi valutato gli effetti delle condizioni generali di ricompensa ambientale sulla motivazione dei ratti ad impegnarsi nel compito. Il numero di omissioni di inizio (cioè, la mancata risposta alla stecca centrale presentata all’inizio di ogni prova entro 40 s) è stato analizzato con omnibus ANOVA con condizioni di ricompensa (stabile, upshift, e downshift crollato attraverso le opzioni HV e LV) come fattore all’interno del soggetto. L’effetto principale della condizione è stato significativo [F(1.09, 7.61)=16.772, p=0.03; Greenhouse-Geisser corretto]: il numero di omissioni è stato significativamente aumentato durante i turni inferiori (p=0.004) e diminuito durante i turni superiori (p=0.017) in valore, rivelando che l’impegno del compito era sensibile al tasso di ricompensa ambientale complessivo.

Pertanto, i roditori sono in grado di conoscere le fondamentali variazioni direzionali dei mezzi di valore nonostante le fluttuazioni stocastiche dei valori di risultato in condizioni di base (cioè l’incertezza attesa). Tuttavia, sono state osservate differenze significative tra HV e LV negli adattamenti di scelta sia per i turni in salita che per quelli in discesa: una maggiore varianza della distribuzione dei risultati alla linea di base ha facilitato l’adattamento comportamentale in risposta ai turni in salita (differenza HV vs LV, p=0,004), ma ha reso gli animali non ottimali durante i turni in discesa (p=0,027); al contrario, la bassa incertezza attesa alla linea di base ha portato a una diminuzione dell’acquisizione dei premi durante i turni in salita. Questi effetti possono essere spiegati da una natura iperbolica del conteggio dei ritardi tra le specie(Freeman et al., 2009; Green et al., 2013; Hwang et al., 2009; Mazur e Biondi, 2009; Mitchell et al., 2015; Rachlin et al., 1991).

Figura 1 – Dati fonte 1.Figura 1—dati fonte 1. Progettazione del compito e prestazioni degli animali intatti.statistiche di sintesi e dati individuali per gli animali ingenui che eseguono il compito.statistiche di sintesi e dati individuali per gli animali ingenui che eseguono il compito.Il nostro compito è progettato per indagare gli effetti dell’incertezza dei risultati previsti sull’apprendimento dei valori.(A) Ogni prova è iniziata con la presentazione degli stimoli nello scomparto centrale del touchscreen. Ai ratti (n = 8) sono stati dati 40 s per avviare una prova. Se 40 s sono passati senza una risposta, la prova è stata segnata come una “omissione di inizio”. In seguito ad una puntura del naso al compartimento centrale, lo stimolo centrale è scomparso e due stimoli di scelta sono stati presentati contemporaneamente in ciascuno dei compartimenti laterali del touchscreen permettendo ad un animale una libera scelta tra due opzioni di ricompensa. Ad un animale sono stati dati 40 s per fare una scelta; la mancata selezione di un’opzione entro questo intervallo di tempo ha fatto sì che la prova venisse valutata come “omissione di scelta” e l’inizio di un ITI. Ogni opzione di risposta è stata associata alla consegna di un pellet di zucchero dopo un intervallo di tempo.(B) I ritardi associati a ciascuna opzione sono stati messi in comune da distribuzioni che sono identiche nel valore medio, ma diverse nella variabilità: LV (bassa variabilità, mostrata in blu) vs. HV (alta variabilità, mostrata in rosso); ~N(µ, σ): μ = 10 s, σ HV=4s, σ LV=1s. Dopo aver stabilito una prestazione stabile, i ratti hanno sperimentato incrementi di valore (µ = 5 s; σ mantenuto costante) e decrementi (μ = 20 s) su ogni opzione in modo indipendente, seguiti da un ritorno alle condizioni di base. Ogni turno e ritorno alla fase di base è durato per cinque sessioni di 60 prove.(C) Indipendentemente dal tipo di turno, gli animali hanno cambiato significativamente la loro preferenza in risposta a tutti i turni (tutti i valori di p<0,05). Tuttavia, sono state osservate differenze significative tra HV e LV negli adattamenti di scelta sia per i turni in salita che per quelli in discesa: una maggiore varianza della distribuzione dei risultati alla linea di base ha facilitato l’adattamento comportamentale in risposta ai turni in salita (differenza HV vs LV, p=0,004), ma ha reso gli animali non ottimali durante i turni in discesa (p=0,027); al contrario, la bassa incertezza prevista alla linea di base ha portato a una diminuzione della ricompensa durante i turni in salita. I dati sono mostrati come mezzi di gruppo per la preferenza delle opzioni durante le condizioni pre-baseline, turno e post-baseline, ± SEM. Gli asterischi indicano differenze statistiche tra le condizioni HV e LV.(D) Il numero di omissioni di avvio è stato significativamente aumentato durante il downshift (p=0,004) e diminuito durante gli upshifts (p=0,017) in valore, indipendentemente dai livelli di incertezza previsti, dimostrando gli effetti delle condizioni generali di ricompensa ambientale sulla motivazione ad impegnarsi nel compito. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0,05, **p<0,01. Le statistiche riassuntive e i dati dei singoli animali sono forniti nella Figura 1 – dati fonte 1.1. DOI:

http://dx.doi.org/10.7554/eLife.27483.00310.7554/eLife.27483.004Cifre dati a 1 fonte 1.Statistiche di sintesi e dati individuali per gli animali ingenui che svolgono il compito.DOI:http://dx.doi.org/10.7554/eLife.27483.004DOI:

http://dx.doi.org/10.7554/eLife.27483.004DOI:

http://dx.doi.org/10.7554/eLife.27483.004

Video 1.Un animale che esegue il compito durante l’upshift sull’opzione HV.Durante un upshift di valore su ogni opzione, la media dei ritardi da premiare è stata ridotta a 5 s con varianza mantenuta uguale a quella delle condizioni di base.DOI:

http://dx.doi.org/10.7554/eLife.27483.005

Video 2.Un animale che esegue il compito durante il turno di riposo su HV.Durante un downshift di valore su ogni opzione, la media dei ritardi da premiare è stata aumentata a 20 s con varianza mantenuta costante.3. DOI:

http://dx.doi.org/10.7554/eLife.27483.006

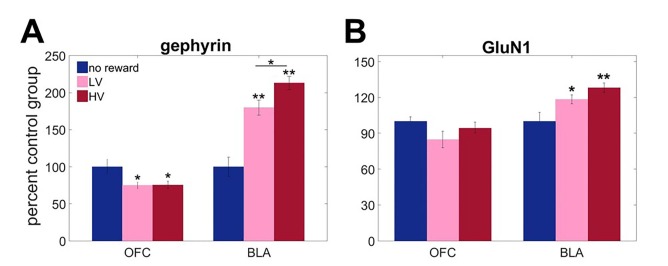

L’esperienza con l’incertezza induce modelli distinti di neuroadattamenti nel BLA e nell’OFC

Abbiamo ipotizzato che l’esperienza con diversi livelli di incertezza dell’esito indurrebbe neuroadattamenti a lungo termine, influenzando la risposta alla stessa ampiezza dei segnali di sorpresa. In particolare, abbiamo valutato l’espressione della gefirina (una proxy affidabile per i recettori GABAAA inseriti nella membrana che mediano la trasmissione inibitoria rapida;[Chhatwal et al., 2005; Tyagarajan et al., 2011]) e GluN1 (una sottounità obbligatoria dei recettori NMDA del glutammato;[Soares et al., 2013]) in BLA e OFC. Tre gruppi separati di animali sono stati addestrati a rispondere agli stimoli visivi su un touchscreen per ottenere una ricompensa dopo ritardi variabili. I valori dei risultati erano identici al nostro compito descritto sopra, ma non è stata data alcuna scelta. Un gruppo è stato addestrato in condizioni di BLA, il secondo in condizioni di HV (pari al numero totale di ricompense ricevute), e il terzo gruppo di controllo non ha ricevuto alcuna ricompensa (n = 8 in ogni gruppo, totale n = 24). Data la limitata quantità di tessuto, ci siamo concentrati sulla NMDA invece che sui recettori AMPA sulla base di precedenti prove che dimostravano effetti dissociabili dei recettori del glutammato ionotropo nel processo decisionale basato sul ritardo(Yates et al., 2015).

Le analisi dell’espressione delle proteine hanno rivelato adattamenti unici alla variabilità del risultato nel BLA, in particolare nella sensibilità allergica GABA. Le misure biochimiche sono state analizzate con ANOVA misto con la regione cerebrale come fattore all’interno del soggetto e l’esperienza di ricompensa (HV, LV o nessuna ricompensa) come fattore tra i soggetti. C’è stato un effetto significativo principale del gruppo [F (2,12)=6,002, p = 0,016] e regione cerebrale x interazione di gruppo[Figura 2A; F (2,12)=41,863, p<0,0001] per la gefirina. Un effetto principale significativo di gruppo [F(2,21)=4,084, p = 0,032] e gruppo x regione cerebrale [F(2,21)=5,291, p = 0,014] interazione sono stati trovati anche per l’espressione GluN1. Le analisi successive hanno identificato l’upregulation incertezza-dipendente di gefirina in BLA [tra i soggetti ANOVA: F(2,21)=45.448, p<0.0001), che è stato massimo dopo la formazione HV (tutti i valori post hoc p confronto post hoc p<0,05). Allo stesso modo, GluN1 ha mostrato una robusta upregulation in risposta al premio esperto in BLA[Figura 2B; F(2,21)=7,092, p=0,004; nessun premio vs LV p=0,045; nessun premio vs HV p=0,002], tuttavia le analisi post hoc non sono riuscite a rilevare una differenza significativa tra l’addestramento HV e LV (p=0,637). In OFC, la gefirina è stata invece downregulated in risposta alle esperienze con ricompensa in generale [F(2,12)=4,445, p=0,036; nessuna ricompensa vs LV p=0,045; nessuna ricompensa vs HV p=0.042] e non dipendeva dalla variabilità della distribuzione dei risultati (confronto post hoc: VH vs VL, p=1); non sono stati osservati cambiamenti in GluN1 [F(2,21)=2,359, p=0,119].10,7554/eLife.27483.007Figure 2.Region-specific alterations in gephyrin and GluN1 expression induced by experience with outcome uncertainty.three separate groups of animals were trained to respond to visual stimmuli on a touchscreen to get a reward after variable delays. I valori dei risultati erano identici al compito principale, ma non è stata data alcuna scelta. Un gruppo è stato addestrato in condizioni di VL, il secondo in condizioni di VH (pari al numero totale di ricompense ricevute) e il terzo gruppo di controllo non ha ricevuto alcuna ricompensa (n = 8 per gruppo). Abbiamo valutato l’espressione di A gefirina (una proxy affidabile per i recettori GABAAA inseriti nella membrana che mediano la trasmissione inibitoria veloce) e B GluN1 (una sottounità obbligatoria dei recettori NMDA del glutammato) in BLA e OFC ventrale. Le analisi biochimiche hanno rivelato l’upregulation incertezza-dipendente in gefirina in BLA, che è stato massimo dopo la formazione HV (p<0,0001). Allo stesso modo, GluN1 ha mostrato una robusta upregulation in risposta all’esperienza di ricompensa in BLA (nessuna ricompensa vs LV p=0,045; nessuna ricompensa vs HV p=0,002), tuttavia le analisi post hoc non sono riuscite a rilevare una differenza significativa tra l’addestramento HV e LV (p=0,637). Nell’OFC ventrale, la gefirina è stata downregolata in risposta alle esperienze con il reward in generale (nessun reward vs LV p=0,045; nessun reward vs HV p=0,042) e non dipendeva dalla variabilità nella distribuzione dei risultati; non sono stati osservati cambiamenti in GluN1. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0.05, **p<0.01 Le statistiche di riepilogo e i dati individuali degli animali sono forniti in Figura 2 dati fonte 1.DOI:http://dx.doi.org/10.7554/eLife.27483.00710.7554/eLife.27483.008Figure2 dati fonte 1.Statistiche di riepilogo e dati individuali per GluN1 e l’espressione della gefirina in BLA e OFC.DOI:http://dx.doi.org/10.7554/eLife.27483.008

Pertanto, sia il BLA che l’OFC subiscono modelli unici di neuroadattamenti in risposta all’esperienza con la variabilità, suggerendo che queste regioni cerebrali possono giocare ruoli complementari, ma dissociabili, nell’apprendimento dei valori sotto l’incertezza dei risultati. Data la complessità comportamentale che i roditori mostrano nel nostro compito, siamo stati in grado di testare direttamente i contributi causali del BLA e dell’OFC ventromediale per valutare l’apprendimento in condizioni di incertezza attesa nella distribuzione degli esiti.

Figura 2 – Dati fonte 1.Figura 2—dati di fonte 1. Alterazioni specifiche della regione nell’espressione della gefirina e del GluN1 indotte dall’esperienza con l’incertezza dell’esito.statistiche di sintesi e dati individuali per il GluN1 e l’espressione della gefirina nel BLA e nell’OFC.statistiche di sintesi e dati individuali per il GluN1 e l’espressione della gefirina nel BLA e nell’OFC.Tre gruppi separati di animali sono stati addestrati a rispondere agli stimoli visivi su un touchscreen per ottenere una ricompensa dopo ritardi variabili. I valori dei risultati erano identici al compito principale, ma non è stata data alcuna scelta. Un gruppo è stato addestrato in condizioni di BLA, il secondo in condizioni di HV (pari al numero totale di ricompense ricevute), e il terzo gruppo di controllo non ha ricevuto alcuna ricompensa (n = 8 per gruppo). Abbiamo valutato l’espressione di A gefirina (una proxy affidabile per i recettori GABAAA inseriti nella membrana che mediano la trasmissione inibitoria veloce) e B GluN1 (una sottounità obbligatoria dei recettori NMDA del glutammato) in BLA e OFC ventrale. Le analisi biochimiche hanno rivelato l’upregulation incertezza-dipendente in gefirina in BLA, che è stato massimo dopo la formazione HV (p<0,0001). Allo stesso modo, GluN1 ha mostrato una robusta upregulation in risposta all’esperienza di ricompensa in BLA (nessuna ricompensa vs LV p=0,045; nessuna ricompensa vs HV p=0,002), tuttavia le analisi post hoc non sono riuscite a rilevare una differenza significativa tra l’addestramento HV e LV (p=0,637). Nell’OFC ventrale, la gefirina è stata downregolata in risposta alle esperienze con il reward in generale (nessun reward vs LV p=0,045; nessun reward vs HV p=0,042) e non dipendeva dalla variabilità nella distribuzione dei risultati; non sono stati osservati cambiamenti in GluN1. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0.05, **p<0.01 Le statistiche di sintesi e i dati dei singoli animali sono forniti in Figura 2 dati fonte 1.1. DOI:

http://dx.doi.org/10.7554/eLife.27483.00710.7554/eLife.27483.008Cifre dati a 2 fonti 1.Statistiche di sintesi e dati individuali per GluN1 e l’espressione della gefirina in BLA e OFC.DOI:http://dx.doi.org/10.7554/eLife.27483.008DOI:

http://dx.doi.org/10.7554/eLife.27483.008DOI:

http://dx.doi.org/10.7554/eLife.27483.008

Contributi causali del BLA e dell’OFC al valore dell’apprendimento sotto l’incertezza

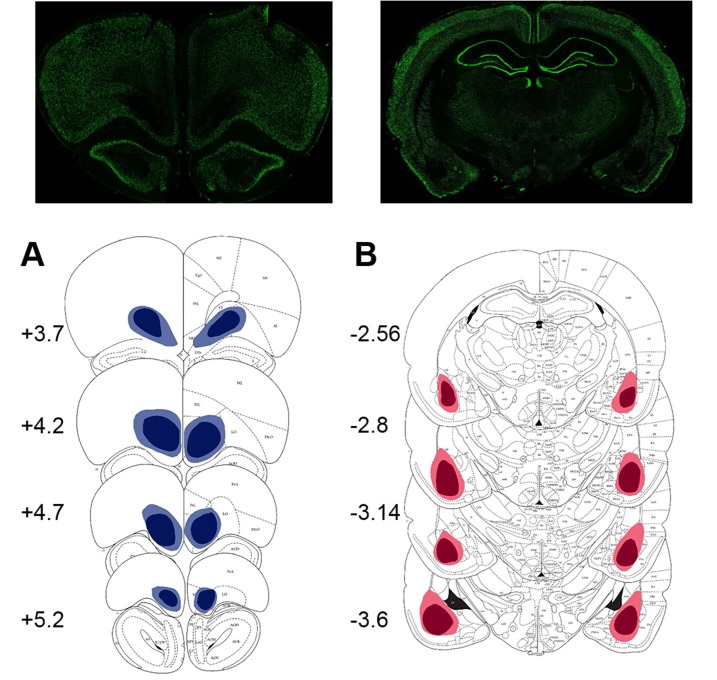

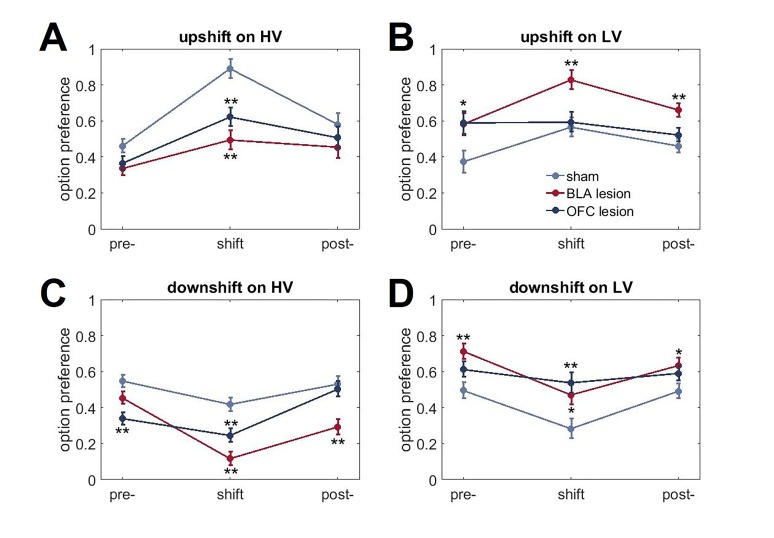

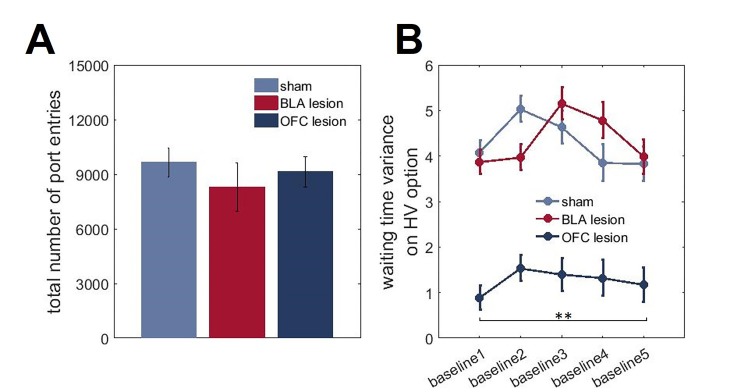

I risultati degli studi sulle lesioni (i siti delle lesioni sono mostrati nella Figura 3) sono stati in linea con le previsioni suggerite dai dati sulle proteine. Poiché eravamo interessati principalmente ai contributi del BLA e dell’OFC all’apprendimento a sorpresa, abbiamo analizzato per la prima volta i cambiamenti massimi nella preferenza delle opzioni in risposta ai cambiamenti in salita e in discesa. Questa analisi ci ha permesso di controllare i potenziali effetti delle lesioni cerebrali sul comportamento di scelta in condizioni di base nel nostro compito. Un omnibus ANOVA con tipo di turno come all’interno del gruppo e sperimentale (finzione, BLA vs lesione OFC; n = 8 per gruppo; totale n = 24) come inter-fattori soggettivi rilevato un significativo effetto principale del gruppo [F(2,21)=11.193, p<0.0001] e gruppo x interazione tipo turno [F(6,63)=9.472, p<0.0001). Le analisi successive hanno mostrato significativi e semplici effetti principali del gruppo sperimentale su tutti i tipi di turno: upshift su HV [F(2,21)=14,723, p<0,0001], upshift su LV [F(2,21)=5,663, p=0,011], downshift su HV [F(2,21)=19,081, p<0,0001], e downshift su LV [F(2,21)=7,189, p=0,004]. I ratti OFC-sollevati erano meno ottimali nel nostro compito: hanno cambiato la loro preferenza di opzione in misura significativamente minore rispetto agli animali di controllo durante i turni in salita su HV (p=0,005) e LV (p=0,039), così come il downshift su LV opzione (p=0,015; Figura 4A). Mentre le lesioni OFC hanno prodotto un marcato deterioramento delle prestazioni, è stato meno chiaro se le alterazioni prodotte dalle lesioni BLA portano a un comportamento non ottimale. Gli animali affetti da BLA hanno modificato la loro preferenza per le opzioni in misura minore durante i turni in aumento dell’HV (p<0,0001), ma sono stati compensati da adattamenti esagerati ai turni in diminuzione dell’HV (p<0,0001; Figura 4A).10.7554/eLife.27483.009Figure 3.Location e l’estensione della lesione prevista (regioni colorate) su sezioni coronali standard attraverso OFC ventrale e BLA.l’estensione delle lesioni è stata valutata dopo il completamento del test comportamentale da colorazione per un marcatore di nuclei neuronali, NeuN.(A) In alto: fotomicrografia rappresentativa di una sezione coronale colorata NeuN che mostra la lesione ventrale OFC. In basso: rappresentazioni di sezioni coronali adattate da(Paxinos e Watson, 1997). I numeri in basso a sinistra di ogni sezione adattata rappresentano la distanza anteriore-posteriore (mm) da Bregma. Blu chiaro e blu scuro rappresentano l’area di lesione massima e minima tra gli animali, rispettivamente. Anche se le coordinate erano rivolte alla regione orbitale ventrale, l’estensione della lesione comprende anche la corteccia orbitale mediale anteriore.(B) In alto: fotomicrografia rappresentativa di una sezione coronale colorata NeuN che mostra la lesione BLA. In basso: rappresentazioni di sezioni coronali con numeri in basso a sinistra di ogni sezione corrispondente che rappresenta la distanza anteriore-posteriore (mm) da Bregma. Rosso chiaro e rosso scuro rappresentano l’area di lesione massima e minima tra gli animali, rispettivamente.DOI:http://dx.doi.org/10.7554/eLife.27483.00910.7554/eLife.27483.010Figure4.Cambiamenti nella preferenza di scelta in risposta ai cambiamenti di valore e le strategie di apprendimento nei gruppi sperimentali.(A) I ratti OFC-lesionati (n = 8) sono stati meno ottimali sul nostro compito: hanno cambiato la loro preferenza opzione in grado significativamente inferiore rispetto agli animali di controllo (n = 8) durante i turni in su su HV (p = 0,005) e LV (p = 0,039), così come il downshift su opzione LV (p = 0,015). Al contrario, gli animali con lesioni BLA (n = 8) hanno modificato la loro preferenza di opzione in misura minore durante i turni in salita (p<0,0001), ma compensati da adattamenti esagerati ai turni in discesa (p<0,0001). La figura 4 mostra la preferenza per l’opzione durante le condizioni pre-baseline, turno e post-baseline in Figura 4, supplemento 1. Abbiamo suddiviso le prove in due tipi: quando i ritardi rientravano nelle distribuzioni sperimentate per ciascuna opzione al baseline( risultatiattesi ) e quelli in cui il grado di sorpresa superava quello previsto per caso( risultati inaspettati). I punteggi di win-stay/lose-shift sono stati calcolati in base ai dati trial-by-trial: un punteggio di 1 è stato assegnato quando gli animali hanno ripetuto la scelta in seguito a risultati migliori della media(win-stay) o sono passati all’altra alternativa in seguito a risultati peggiori della media(lose-shift). Gli animali sham-lesionati hanno dimostrato una maggiore sensibilità a feedback inattesi (valori di p < 0,001). Analogamente, la capacità di distinguere tra risultati attesi e inaspettati è rimasta intatta negli animali con lesioni BLA (valori p < 0,001), sebbene la loro sensibilità al feedback sia complessivamente diminuita. Al contrario, gli animali colonizzati da OFC non sono riusciti a distinguere le fluttuazioni attese da quelle inattese.(C,D) Per esaminare la traiettoria di apprendimento abbiamo analizzato l’evoluzione della preferenza delle opzioni. Gli animali con lesioni BLA erano indistinguibili dai controlli durante i turni sull’opzione LV. Mentre, questo gruppo sperimentale ha dimostrato un apprendimento significativamente attenuato durante l’upshift su HV (p valori < 0,0001 per tutte le sessioni) e potenziato le prestazioni durante le sessioni da 3 a 5 su HV downshift (p valori < 0,05) rispetto al finto gruppo. Al contrario, l’apprendimento negli animali affetti da OFC è stato influenzato dalla maggior parte dei tipi di turno: questi animali hanno dimostrato un apprendimento significativamente più lento durante le sessioni da 3 a 5 durante l’upshift su HV (valori p < 0,05), tutte le sessioni durante l’upshift su LV (valori p < 0,05) e le sessioni da 3 a 5 durante il downshift su LV (valori p < 0,05). La sessione 0 si riferisce alla preferenza dell’opzione baseline/pre-shift. Nonostante queste differenze nelle risposte ai cambiamenti di valore in condizioni di incertezza, non abbiamo osservato alcun deficit nell’apprendimento delle ricompense di base negli animali affetti da BLA o OFC, come mostrato nella Figura 4, supplemento 2. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0.05, **p<0.01. Le statistiche di riepilogo e i dati individuali degli animali sono forniti in Figura 4 dati da fonte 1 e Figura 4 dati da fonte 2.DOI:http://dx.doi.org/10.7554/eLife.27483.01010.7554/eLife.27483.011Figuredati da 4 fonti 1.Statistiche di riepilogo e dati individuali per i cambiamenti nelle preferenze di scelta e nelle strategie di apprendimento.DOI:http://dx.doi.org/10.7554/eLife.27483.01110.7554/eLife.27483.012Figure4 dati fonte 2.Statistiche di sintesi e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai cambiamenti.DOI:http://dx.doi.org/10.7554/eLife.27483.01210.7554/eLife.27483.013FigureSupplemento a 4 cifre 1.Cambiamenti nel comportamento di scelta in risposta ai cambiamenti di valore.(A) Entrambi i gruppi di lesioni hanno dimostrato un ridotto adattamento ai cambiamenti di valore dell’opzione HV (p<0.01).(B). Gli animali con lesioni BLA hanno scelto l’opzione LV più frequentemente rispetto ai controlli quando il suo valore è stato aumentato (p<0,01).(C, D) Sia gli animali con lesioni BLA che quelli con lesioni OFC hanno anche mostrato una riduzione della preferenza per l’opzione HV (p<0,01) e un aumento della preferenza per l’opzione LV (p<0,05) durante i turni inferiori rispetto agli animali finti. Questo modello di risultati può essere spiegato da cambiamenti nel comportamento di scelta anche in condizioni di base in BLA- e OFC-lesionati animali che hanno interagito con la capacità dei ratti di conoscere i turni di valore. Infatti, ci sono state differenze significative di gruppo nelle preferenze di base prima del turno. I dati sono mostrati come mezzi di gruppo per le preferenze di opzione durante le condizioni pre-baseline, turno e post-baseline, ± SEM. *p<0,05, **p<0,01. Le statistiche di riepilogo e i dati dei singoli animali sono forniti in Figura 4 dati fonte 2.DOI:http://dx.doi.org/10.7554/eLife.27483.01310.7554/eLife.27483.014Figuresupplemento a 4 cifre 2.La mancanza di differenze di gruppo nell’apprendimento di base di ricompensa.I nostri interventi chirurgici hanno avuto luogo prima di qualsiasi esposizione all’apparato di prova o di formazione comportamentale. Entrambi i gruppi lesionati erano indistinguibili dai controlli nelle fasi iniziali del compito. Durante il pre-formazione, gli animali hanno imparato a rispondere agli stimoli visivi presentati nello scomparto centrale dello schermo entro un intervallo di tempo di 40 s per ricevere la ricompensa dello zucchero (risposta allo stimolo). Successivamente, i ratti hanno imparato ad avviare la prova puntando il naso sullo stimolo quadrato bianco brillante presentato nello scomparto centrale dello schermo tattile; questa risposta è stata seguita dalla scomparsa dello stimolo centrale e dalla presentazione di un’immagine target in uno scomparto laterale dello schermo tattile (avvio della prova). Le risposte all’immagine target hanno prodotto una ricompensa immediata. L’ultima fase dell’addestramento è stata somministrata per familiarizzare gli animali con i risultati ritardati. Il protocollo è stato identico a quello della fase precedente, ad eccezione del fatto che le risposte all’immagine target e la consegna della ricompensa sono state separate da un ritardo stabile di 5 s (certi ritardi di 5 s).(A, B). Gli animali di tutti i gruppi hanno impiegato un numero simile di giorni per imparare a ficcare il naso agli stimoli visivi sul touchscreen per ricevere i premi di zucchero (p=0,796) e per avviare una prova (p=0,821).(C, D). Non ci sono state differenze di gruppo nelle risposte all’introduzione di un intervallo di ritardo di 5 s durante il pre-formazione (p=0,518) o nel numero di sessioni per raggiungere una prestazione stabile durante la fase iniziale di base del nostro compito di incertezza (p=0,772). I dati sono mostrati come mezzi di gruppo ± SEM.DOI:http://dx.doi.org/10.7554/eLife.27483.014

Oltre ad esaminare i cambiamenti massimi nelle preferenze delle opzioni, abbiamo analizzato i dati comportamentali con un ANOVA omnibus con tipo di turno e fase di turno (baseline pre-movimento, performance del turno e baseline post-movimento) come all’interno del gruppo di soggetti e del gruppo sperimentale come fattori tra i soggetti. Questo test ha rilevato in modo simile un significativo tipo di spostamento x fase x interazione di gruppo [F(6.9,72.5)=7.41, p<0.0001; Greenhouse-Geisser corretto, Figura 4-figure supplement 1). Coerentemente con le analisi precedenti, i test post hoc hanno rivelato adattamenti ridotti per valutare gli uphifts sull’opzione HV in entrambi i gruppi di lesioni (p<0,01). Tuttavia, abbiamo anche osservato scelte più frequenti dell’opzione LV quando il suo valore è stato aumentato in animali con lesioni BLA (p<0,01) così come una ridotta preferenza per l’opzione HV (p<0,01) e una maggiore preferenza per l’opzione LV (p<0,05) durante i turni di lavoro in entrambi i gruppi di lesioni rispetto agli animali di controllo. Questo modello di risultati può essere spiegato da cambiamenti nel comportamento di scelta anche in condizioni di base in animali con lesioni BLA e OFC che hanno interagito con la capacità dei ratti di conoscere i turni di valore.

Il successo del nostro compito richiedeva agli animali di distinguere tra la varianza delle distribuzioni dei risultati in condizioni di stabilità e i sorprendenti spostamenti di valore, nonostante il fatto che le distribuzioni di ritardo alla linea di base e le distribuzioni durante il turno si sovrappongano parzialmente. Per valutare se gli animali nei gruppi lesionati hanno adottato una strategia diversa e hanno dimostrato un’alterata sensibilità a risultati sorprendenti, abbiamo esaminato le risposte del turno di vincita/perdita. I punteggi del win-stay e del lose-shift sono stati calcolati sulla base di dati prova per prova simili ai rapporti precedenti(Faraut et al., 2016; Imhof et al., 2007; Worthy et al., 2013): un punteggio di 1 è stato assegnato quando gli animali hanno ripetuto la scelta in seguito a risultati migliori della media(win-stay) o sono passati all’altra alternativa in seguito a risultati peggiori della media(lose-shift). Le prove win-shift e lose-stay sono state conteggiate come 0 s. Per valutare in particolare se i ratti distinguevano le fluttuazioni attese dai cambiamenti sorprendenti, abbiamo diviso le prove in due tipi: quando i ritardi rientravano nelle distribuzioni sperimentate per ogni opzione al baseline (risultati attesi) e quelle in cui il grado di sorpresa superava quello previsto per caso. L’algoritmo utilizzato per questa analisi ha tenuto traccia di tutti i ritardi sperimentati in condizioni di base prima della prova in corso per ogni singolo animale. Su ogni prova, abbiamo trovato il valore del ritardo minimo e massimo. Se il valore del ritardo attuale rientrava in questo intervallo, il risultato è stato classificato come previsto. Se il ritardo attuale non rientrava in questa distribuzione, il risultato di questa prova è stato classificato come inaspettato (sorprendente).

I punteggi win-stay e lose-shift sono stati calcolati separatamente per ogni tipo di trial e le loro probabilità (punteggio sommario diviso per il numero di trial) per entrambi i tipi di trial sono stati sottoposti ad ANOVA con strategia come all’interno del soggetto e gruppo sperimentale come fattori tra i soggetti. Le nostre analisi hanno indicato una significativa strategia x interazione del gruppo sperimentale [F(6,63)=9,912, p<0,0001]. Criticamente, gli animali sham-lesioned dimostrato una maggiore sensibilità a risultati inaspettati rispetto alle fluttuazioni prevedibili sia per le vittorie e le perdite(Figura 4B, p valori <0,0001). Allo stesso modo, la capacità di distinguere tra risultati attesi e inaspettati era intatta negli animali colonizzati con BLA (valori p < 0,001), anche se la loro sensibilità al feedback è diminuita nel complesso. Al contrario, gli animali affetti da OFC non sono riusciti a distinguere le fluttuazioni prevedibili da quelle sorprendenti. È interessante notare che gli animali con finto e BLA hanno dimostrato bassi punteggi di vincita e perdita di turno quando erano attesi risultati di prova; questi animali hanno avuto più probabilità di spostarsi dopo risultati migliori della media e di persistere con le loro scelte dopo risultati peggiori. Oltre all’insensibilità al feedback, tale comportamento può derivare da un aumento del comportamento esplorativo in risposta alle vittorie e all’inflessibilità comportamentale dopo le perdite. Inoltre, quando i risultati sono relativamente stabili e prevedibili, i ratti possono essere più sensibili alla storia delle ricompense a lungo termine e fare meno affidamento sull’esito di una data prova.

Figura 3.Posizione ed estensione della lesione prevista (regioni colorate) su sezioni coronali standard attraverso OFC ventrale e BLA.L’estensione delle lesioni è stata valutata dopo il completamento del test comportamentale mediante colorazione per un marker di nuclei neuronali, NeuN.(A) In alto: fotomicrografia rappresentativa di una sezione coronale colorata NeuN che mostra la lesione ventrale OFC. In basso: rappresentazioni di sezioni coronali adattate da(Paxinos e Watson, 1997). I numeri in basso a sinistra di ogni sezione adattata rappresentano la distanza anteriore-posteriore (mm) da Bregma. Blu chiaro e blu scuro rappresentano l’area di lesione massima e minima tra gli animali, rispettivamente. Anche se le coordinate erano rivolte alla regione orbitale ventrale, l’estensione della lesione comprende anche la corteccia orbitale mediale anteriore.(B) In alto: fotomicrografia rappresentativa di una sezione coronale colorata NeuN che mostra la lesione BLA. In basso: rappresentazioni di sezioni coronali con numeri in basso a sinistra di ogni sezione corrispondente che rappresenta la distanza anteriore-posteriore (mm) da Bregma. Rosso chiaro e rosso scuro rappresentano l’area di lesione massima e minima tra gli animali, rispettivamente.DOI:

http://dx.doi.org/10.7554/eLife.27483.009

Figura 4-figure supplement 2.Statistiche di riepilogo e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai cambiamenti delle preferenze di scelta e delle strategie di apprendimento.statistiche di riepilogo e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai cambiamenti delle preferenze di scelta e delle strategie di apprendimento.statistiche di riepilogo e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai cambiamenti delle preferenze di scelta e delle strategie di apprendimento.statistiche di riepilogo e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai cambiamenti di valore.cambiamenti del comportamento di scelta in risposta ai cambiamenti di valore.la mancanza di differenze di gruppo nell’apprendimento di base dei premi.(A) I ratti OFC-conservati (n = 8) sono stati meno ottimali nel nostro compito: hanno cambiato la loro preferenza di opzione in misura significativamente minore rispetto agli animali di controllo (n = 8) durante i turni in salita su HV (p=0.005) e LV (p=0.039), così come il turno in discesa su LV opzione (p=0.015). Al contrario, gli animali con lesioni BLA (n = 8) hanno modificato la loro preferenza di opzione in misura minore durante i turni in salita (p<0,0001), ma compensati da adattamenti esagerati ai turni in discesa (p<0,0001). I gruppi indicano la preferenza per l’opzione durante le condizioni pre-baseline, turno e post-baseline sono mostrati in Figura 4-figure supplement 1. Abbiamo suddiviso le prove in due tipi: quando i ritardi rientravano nelle distribuzioni sperimentate per ciascuna opzione al baseline( risultatiattesi ) e quelli in cui il grado di sorpresa superava quello previsto per caso( risultati inaspettati). I punteggi di win-stay/lose-shift sono stati calcolati in base ai dati trial-by-trial: un punteggio di 1 è stato assegnato quando gli animali hanno ripetuto la scelta in seguito a risultati migliori della media(win-stay) o sono passati all’altra alternativa in seguito a risultati peggiori della media(lose-shift). Gli animali sham-lesionati hanno dimostrato una maggiore sensibilità a feedback inattesi (valori di p < 0,001). Analogamente, la capacità di distinguere tra esiti attesi e inaspettati era intatta negli animali con lesioni BLA (valori p < 0,001), anche se la loro sensibilità al feedback è complessivamente diminuita. Al contrario, gli animali colonizzati da OFC non sono riusciti a distinguere le fluttuazioni attese da quelle inattese.(C,D) Per esaminare la traiettoria di apprendimento abbiamo analizzato l’evoluzione della preferenza delle opzioni. Gli animali con lesioni BLA erano indistinguibili dai controlli durante i turni sull’opzione LV. Mentre, questo gruppo sperimentale ha dimostrato un apprendimento significativamente attenuato durante l’upshift su HV (p valori < 0,0001 per tutte le sessioni) e potenziato le prestazioni durante le sessioni da 3 a 5 su HV downshift (p valori < 0,05) rispetto al finto gruppo. Al contrario, l’apprendimento negli animali affetti da OFC è stato influenzato dalla maggior parte dei tipi di turno: questi animali hanno dimostrato un apprendimento significativamente più lento durante le sessioni da 3 a 5 durante l’upshift su HV (valori p < 0,05), tutte le sessioni durante l’upshift su LV (valori p < 0,05) e le sessioni da 3 a 5 durante il downshift su LV (valori p < 0,05). La sessione 0 si riferisce alla preferenza dell’opzione baseline/pre-shift. Nonostante queste differenze nelle risposte ai cambiamenti di valore in condizioni di incertezza, non abbiamo osservato alcun deficit nell’apprendimento delle ricompense di base negli animali affetti da BLA o OFC, come mostrato nella Figura 4, supplemento 2. I dati sono mostrati come mezzi di gruppo per condizione +SEM. *p<0.05, **p<0.01. Le statistiche riassuntive e i dati dei singoli animali sono forniti nella Figura 4 dati 1 e nella Figura 4 dati 2.DOI:

http://dx.doi.org/10.7554/eLife.27483.01010.7554/eLife.27483.011Cifre dati a 4 fonti 1.Statistiche di sintesi e dati individuali per i cambiamenti nelle preferenze di scelta e nelle strategie di apprendimento.DOI:http://dx.doi.org/10.7554/eLife.27483.011DOI:

http://dx.doi.org/10.7554/eLife.27483.01110.7554/eLife.27483.012Cifre dati a 4 fonti 2.Statistiche di sintesi e dati individuali che dimostrano le differenze di gruppo sperimentali in risposta ai turni.DOI:http://dx.doi.org/10.7554/eLife.27483.012DOI:

http://dx.doi.org/10.7554/eLife.27483.012DOI:

http://dx.doi.org/10.7554/eLife.27483.011DOI:

http://dx.doi.org/10.7554/eLife.27483.012(A) Entrambi i gruppi di lesioni hanno dimostrato adattamenti ridotti per valutare gli upshifts sull’opzione HV (p<0,01).(B). Gli animali affetti da BLA hanno scelto l’opzione LV più frequentemente rispetto ai controlli quando il suo valore è stato aumentato (p<0,01).(C, D) Sia gli animali con lesioni BLA che quelli con lesioni OFC hanno anche mostrato una riduzione della preferenza per l’opzione HV (p<0,01) e un aumento della preferenza per l’opzione LV (p<0,05) durante i turni inferiori rispetto agli animali finti. Questo modello di risultati può essere spiegato da cambiamenti nel comportamento di scelta anche in condizioni di base in BLA- e OFC-lesionati animali che hanno interagito con la capacità dei ratti di conoscere i turni di valore. Infatti, ci sono state differenze significative di gruppo nelle preferenze di base prima del turno. I dati sono mostrati come mezzi di gruppo per le preferenze di opzione durante le condizioni pre-baseline, turno e post-baseline, ± SEM. *p<0,05, **p<0,01. Le statistiche di riepilogo e i dati dei singoli animali sono forniti nella figura 4 dati fonte 2.DOI:

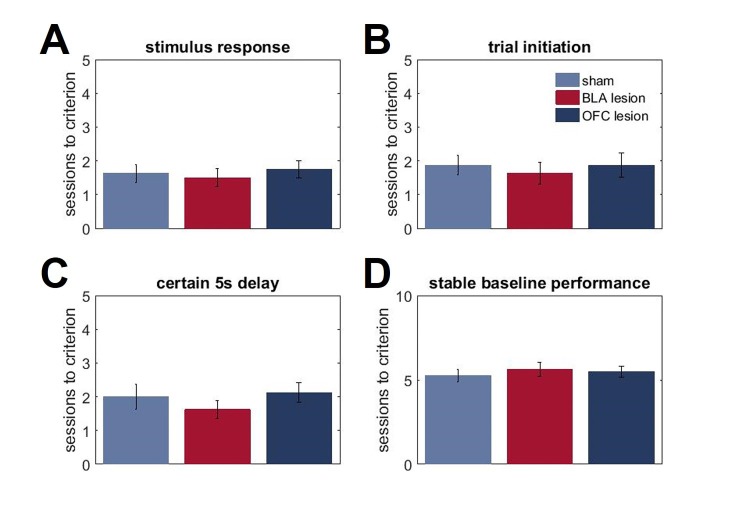

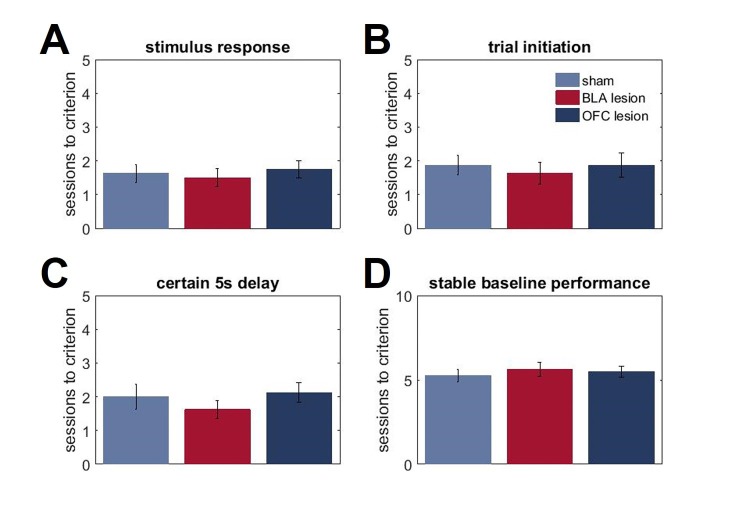

http://dx.doi.org/10.7554/eLife.27483.013I nostri interventi chirurgici hanno avuto luogo prima di qualsiasi esposizione all’apparato di prova o di addestramento comportamentale. Entrambi i gruppi lesionati erano indistinguibili dai controlli nelle fasi iniziali del compito. Durante il pre-formazione, gli animali hanno imparato a rispondere agli stimoli visivi presentati nello scomparto centrale dello schermo entro un intervallo di tempo di 40 s per ricevere la ricompensa dello zucchero (risposta allo stimolo). Successivamente, i ratti hanno imparato ad avviare la prova puntando il naso sullo stimolo quadrato bianco brillante presentato nello scomparto centrale dello schermo tattile; questa risposta è stata seguita dalla scomparsa dello stimolo centrale e dalla presentazione di un’immagine target in uno scomparto laterale dello schermo tattile (avvio della prova). Le risposte all’immagine target hanno prodotto una ricompensa immediata. L’ultima fase dell’addestramento è stata somministrata per familiarizzare gli animali con i risultati ritardati. Il protocollo è stato identico a quello della fase precedente, ad eccezione del fatto che le risposte all’immagine target e la consegna della ricompensa sono state separate da un ritardo stabile di 5 s (certi ritardi di 5 s).(A, B). Gli animali di tutti i gruppi hanno impiegato un numero simile di giorni per imparare a ficcare il naso agli stimoli visivi sul touchscreen per ricevere i premi di zucchero (p=0,796) e per avviare una prova (p=0,821).(C, D). Non ci sono state differenze di gruppo nelle risposte all’introduzione di un intervallo di ritardo di 5 s durante il pre-formazione (p=0,518) o nel numero di sessioni per raggiungere una prestazione stabile durante la fase iniziale di base del nostro compito di incertezza (p=0,772). I dati sono mostrati come mezzi di gruppo ± SEM.DOI:

http://dx.doi.org/10.7554/eLife.27483.014

Figura 4-figure supplement 1.Cambiamenti nel comportamento di scelta in risposta a spostamenti di valore.(A) Entrambi i gruppi di lesioni hanno dimostrato una riduzione degli adattamenti per gli upshifts di valore sull’opzione HV (p<0,01).(B). Gli animali con lesioni BLA hanno scelto l’opzione LV più frequentemente rispetto ai controlli quando il suo valore è stato aumentato (p<0,01).(C, D) Sia gli animali con lesioni BLA che quelli con lesioni OFC hanno anche mostrato una riduzione della preferenza per l’opzione HV (p<0,01) e un aumento della preferenza per l’opzione LV (p<0,05) durante i turni inferiori rispetto agli animali finti. Questo modello di risultati può essere spiegato da cambiamenti nel comportamento di scelta anche in condizioni di base in BLA- e OFC-lesionati animali che hanno interagito con la capacità dei ratti di conoscere i turni di valore. Infatti, ci sono state significative differenze di gruppo nelle preferenze di base prima del turno. I dati sono mostrati come mezzi di gruppo per le preferenze di opzione durante le condizioni pre-baseline, turno e post-baseline, ± SEM. *p<0,05, **p<0,01. Le statistiche di riepilogo e i dati dei singoli animali sono forniti nella figura 4 dati fonte 2.DOI:

http://dx.doi.org/10.7554/eLife.27483.013

Figura 4-figure supplement 2.La mancanza di differenze di gruppo nell’apprendimento premiante di base.I nostri interventi chirurgici hanno avuto luogo prima di qualsiasi esposizione all’apparato di prova o all’addestramento comportamentale. Entrambi i gruppi lesionati erano indistinguibili dai controlli nelle fasi iniziali del compito. Durante il pre-formazione, gli animali hanno imparato a rispondere agli stimoli visivi presentati nello scomparto centrale dello schermo entro un intervallo di tempo di 40 s per ricevere la ricompensa di zucchero (risposta allo stimolo). Successivamente, i ratti hanno imparato ad avviare la prova puntando il naso sullo stimolo quadrato bianco brillante presentato nello scomparto centrale dello schermo tattile; questa risposta è stata seguita dalla scomparsa dello stimolo centrale e dalla presentazione di un’immagine target in uno scomparto laterale dello schermo tattile (avvio della prova). Le risposte all’immagine target hanno prodotto una ricompensa immediata. L’ultima fase dell’addestramento è stata somministrata per familiarizzare gli animali con i risultati ritardati. Il protocollo è stato identico a quello della fase precedente, ad eccezione del fatto che le risposte all’immagine target e la consegna della ricompensa sono state separate da un ritardo stabile di 5 s (certi ritardi di 5 s).(A, B). Gli animali di tutti i gruppi hanno impiegato un numero simile di giorni per imparare a ficcare il naso agli stimoli visivi sul touchscreen per ricevere i premi di zucchero (p=0,796) e per avviare una prova (p=0,821).(C, D). Non ci sono state differenze di gruppo nelle risposte all’introduzione di un intervallo di ritardo di 5 s durante il pre-formazione (p=0,518) o nel numero di sessioni per raggiungere una prestazione stabile durante la fase iniziale di base del nostro compito di incertezza (p=0,772). I dati sono mostrati come mezzi di gruppo ± SEM.DOI:

http://dx.doi.org/10.7554/eLife.27483.014

Le lesioni al BLA e all’OFC alterano la traiettoria di apprendimento

Per esaminare la traiettoria di apprendimento abbiamo analizzato l’evoluzione della preferenza delle opzioni durante i turni di lavoro. In particolare, abbiamo sottoposto i dati sessione per sessione durante ogni swift ad un ANOVA omnibus con sessione di test (da 1 a 5; la sessione 0 nella Figura 4C,D corrisponde alla preferenza dell’opzione pre-shift) e il tipo di turno come all’interno del gruppo e il gruppo sperimentale tra i fattori del soggetto. Questa analisi ha rivelato una sessione a tre vie x tipo di turno x interazione di gruppo [F(8.73, 91.71)=8.418, p=0.002; Greenhouse-Geisser corretto, Figura 4C,D]. Le analisi successive hanno identificato significative interazioni a due vie sessione x interazioni di gruppo per ogni tipo di turno [upshift su HV: F(5.24, 55.04)=3.585, p=0.006; downshift su HV: F(4.14, 43.452)=25.646, p<0.0001; salita su BT: F(2.59,27.14) = 4.378, p=0.016; discesa su BT: F(3.69, 38.767)=6.768, p<0.0001; tutti i Greenhouse-Geisser corretti]. Gli animali con lesioni BLA erano indistinguibili dai controlli durante i turni sull’opzione BT. Tuttavia, questo gruppo sperimentale ha dimostrato l’apprendimento significativamente attenuato durante il turno in salita su HV (p valori < 0,0001 per tutte le sessioni) e potenziato le prestazioni durante le sessioni da 3 a cinque durante i turni in discesa su HV (p valori < 0,05) rispetto al gruppo finto. Al contrario, l’apprendimento negli animali affetti da OFC è stato influenzato dalla maggior parte dei tipi di turno: questi animali hanno dimostrato un apprendimento significativamente più lento durante le sessioni da 3 a 5 durante il turno superiore su HV (valori p < 0,05), tutte le sessioni durante il turno superiore su LV (valori p < 0,05) e le sessioni da 3 a 5 durante il turno inferiore su LV (valori p < 0,05).

Nonostante queste differenze nelle risposte ai cambiamenti di valore, non abbiamo osservato alcun deficit nell’apprendimento delle ricompense di base sia negli animali affetti da BLA che da OFC. I nostri interventi chirurgici hanno avuto luogo prima di qualsiasi esposizione all’apparato di prova o di formazione comportamentale, ma entrambi i gruppi lesionati erano indistinguibili dai controlli nelle prime fasi del compito. Tutti gli animali hanno impiegato un numero simile di giorni per imparare a ficcare il naso negli stimoli visivi sul touchscreen per ricevere premi di zucchero [F(2,21)=0,231, p=0,796] e per avviare una prova [F(2,21)=0,199, p=0,821]. Allo stesso modo, non ci sono state differenze di gruppo nelle risposte all’introduzione di un intervallo di ritardo di 5 s durante il pre-formazione [F(2,21)=0,679, p=0,518] o nel numero di sessioni per raggiungere una performance stabile durante la fase iniziale di base del nostro compito di incertezza [F92,21)=0,262, p=0,772; Figura 4-figure supplement 2].

Contributi complementari del BLA e dell’OFC al valore dell’apprendimento sotto l’incertezza rivelato dalla modellazione computazionale

Abbiamo adattato diverse versioni dei modelli RL alle scelte di prova per ogni animale separatamente. In particolare, abbiamo considerato il modello standard Rescorla-Wagner (RW) e un modello dinamico del tasso di apprendimento (Pearce-Hall, PH). Il modello RW aggiorna i valori delle opzioni in risposta agli RPE (cioè il grado di sorpresa) con un tasso di apprendimento costante, al contrario il modello PH permette di facilitare l’apprendimento con un feedback sorprendente (cioè, il tasso di apprendimento è scalato secondo gli errori di previsione assoluta). Abbiamo anche confrontato modelli in cui l’incertezza del risultato atteso viene appresa contemporaneamente al valore e scala l’impatto degli errori di previsione sul valore (RW+incertezza attesa) e sull’aggiornamento del tasso di apprendimento (modello completo). Il numero totale di parametri liberi, il BIC e i valori dei parametri per ogni modello e gruppo sperimentale sono forniti nella Tabella 1. Il comportamento del gruppo di controllo è stato meglio catturato dal modello dinamico del tasso di apprendimento con la scala RPE proporzionale all’incertezza attesa del risultato e la facilitazione dell’apprendimento in risposta ad un feedback sorprendente (modello completo; Tabella 1, i valori BIC più bassi indicano un migliore adattamento). Pertanto, i ratti nel nostro esperimento hanno aumentato i tassi di apprendimento in risposta alla sorpresa per massimizzare il tasso di acquisizione di ricompense, ma solo se i risultati inaspettati non erano probabilmente dovuti a fluttuazioni di valore in condizioni altrimenti stabili. Coerentemente con l’apprendimento attenuato osservato in animali con lesioni BLA, la performance prova per prova in questi animali è stata meglio adattata dal modello di incertezza RW + attesa, dimostrando la perdita selettiva del potenziamento dell’apprendimento in risposta alla sorpresa e preservando la scala RPE con incertezza attesa in questi animali, portando ad un apprendimento più lento rispetto agli animali intatti durante i turni sull’opzione HV. Al contrario, le prestazioni degli animali affetti da OFC sono state meglio considerate dal modello PH, suggerendo che, mentre questi animali aumentavano ancora i tassi di apprendimento in risposta alla sorpresa, essi erano insensibili all’incertezza attesa del risultato. Inoltre, i tassi di apprendimento complessivi sono stati ridotti negli animali con lesioni da OFC (p=0,01 rispetto al finto gruppo). Infine, abbiamo osservato valori significativamente più bassi di β (parametro della temperatura inversa nella regola di scelta softmax) sia negli animali con BLA che in quelli con OFC [F(2,21)=4,88, p=0,018; sham vs BLA: p<0,0001; sham vs OFC: p<0,0001], suggerendo che il loro comportamento è meno stabile, più esplorativo e meno dipendente dalla differenza dei valori di risultato appresi rispetto al gruppo di controllo.10.7554/eLife.27483.015Tabella 1.Confronto tra modelli. I valori BIC più bassi indicano un migliore adattamento del modello (in grassetto); il numero di parametri liberi e i valori dei parametri ± SEM del modello di migliore adattamento sono forniti per ogni gruppo. Le scelte di prova per prova degli animali intatti sono state meglio catturate dal modello dinamico del tasso di apprendimento che incorpora la scala RPE proporzionale all’incertezza attesa e la facilitazione dell’apprendimento in risposta a risultati sorprendenti (modello completo). Le lesioni BLA hanno eliminato selettivamente la scalatura del tasso di apprendimento in risposta alla sorpresa (il modello RW+incertezza attesa ha fornito il miglior adattamento). Mentre gli animali con lesioni da OFC continuavano ad aumentare i tassi di apprendimento in risposta ad eventi sorprendenti (modello PH), in questo gruppo si è persa la scala RPE proporzionale all’incertezza attesa dell’esito. Inoltre, i tassi di apprendimento complessivi sono stati ridotti negli animali con lesioni da OFC (p=0,01). Infine, abbiamo osservato valori significativamente più bassi di β (parametro della temperatura inversa nella regola di scelta softmax) in entrambi gli animali affetti da BLA e OFC (p<0.0001), suggerendo che il loro comportamento è meno stabile, più esplorativo e meno dipendente dalla differenza dei valori di risultato appresi. Gli asterischi indicano valori dei parametri che erano significativamente diversi dal gruppo di controllo (in grassetto).DOI:http://dx.doi.org/10.7554/eLife.27483.015ModelRWPHRW+incertezza attesaFull#parametri3456BICparametro ± SEMkα, valueβηα, riskω sham26519.3926900.6626384.1825681.70,29 ± 0,030,09 ± 0,0114,1 ± 0,990,33 ± 0,040,56 ± 0,083,04 ± 0,11 Lesione da BLA26201.8926864,7425153.8227162.820.32 ± 0.020.07 ± 0.017.4 ± 0.6*n/a0,58 ± 0,063,40 ± 0,4OFC lesione24292,5423171.4624630.9223994.50.3 ± 0.050.05 ± 0.01*5.5 ± 0.68*0/32 ± 0.05n/dn/d

Gli animali con lesioni ventrali OFC non rappresentano l’incertezza prevista nelle distribuzioni dei tempi di attesa

Per ottenere ulteriori approfondimenti sulle rappresentazioni dei risultati nei nostri gruppi sperimentali, abbiamo analizzato la microstruttura del comportamento di scelta dei ratti. In particolare, abbiamo affrontato se BLA e lesioni ventrali OFC ventrali alterato la capacità degli animali di formare aspettative circa i tempi di consegna dei premi. In ogni prova durante tutte le condizioni di base, in cui i valori complessivi delle opzioni LV e HV erano equivalenti, le entrate del porto di ricompensa sono state registrate in contenitori da 1 s durante il periodo di attesa (dopo che un ratto aveva indicato la sua scelta e fino alla consegna della ricompensa; gli istogrammi delle vere distribuzioni dei ritardi e delle azioni di ricerca di ricompensa degli animali normalizzati al numero totale di entrate del porto di ricompensa sono mostrati nella Figura 5). Questi dati sono stati analizzati con un ANOVA con il contenitore di tempo come all’interno di un gruppo di lesioni e tra i fattori soggettivi. Non ci sono state differenze significative nella media dei tempi di consegna dei premi previsti tra i gruppi [F(5,42)=1,064, p=0,394]. Allo stesso modo, tutti i gruppi sono stati abbinati nel numero totale di voci di porta di ricompensa [F(2,21)=0,462, p=0,636; Figura 5-figure supplement 1]. Tuttavia, è stata rilevata una differenza significativa nelle variazioni delle distribuzioni delle entrate dei porti di ricompensa [χ 2(209)=4004.054, p<0,0001]. Mentre le distribuzioni dei tempi di ricerca dei premi nei ratti colonizzati dal BLA erano indistinguibili da quelle degli animali di controllo e dai ritardi reali, gli animali colonizzati dall’OFC concentravano le loro entrate dei porti di ricompensa nell’intervallo di tempo corrispondente ai ritardi medi, suggerendo che mentre questi animali possono dedurre i risultati medi, non riescono a rappresentare la varianza (ad es, 10.7554/eLife.27483.016Cifra 5.Gli animali con lesioni ventrali OFC non rappresentano l’incertezza prevista nei ritardi di ricompensa.Abbiamo valutato se le lesioni BLA e le lesioni ventrali OFC alterano la capacità degli animali di formare aspettative sui tempi di consegna della ricompensa. In ogni prova durante tutte le condizioni di base in cui il valore complessivo delle opzioni LV e HV era equivalente, le entrate del porto di ricompensa sono state registrate in contenitori da 1 s durante il periodo di attesa. Non ci sono state differenze significative nelle modalità dei tempi di consegna dei premi previsti per i vari gruppi (p=0,394). Allo stesso modo, i gruppi sono stati uguagliati nel numero totale di entrate del porto a pagamento (p=0,636), come mostrato nella figura 5-figure supplement 1. Mentre le distribuzioni dei tempi di ricerca dei premi negli animali con lesioni BLA erano indistinguibili da quelle degli animali di controllo e dai ritardi reali (A-F), gli animalicon lesioni OFC hanno concentrato le loro registrazioni dei porti di ricompensa nell’intervallo di tempo corrispondente ai ritardi medi (G,H), suggerendo che mentre questi animali possono dedurre il risultato medio, non riescono a rappresentare la varianza (cioè l’incertezza attesa). Abbiamo anche considerato le variazioni dei tempi di attesa nel corso del nostro compito; questi dati sono mostrati nella Figura 5-figure supplement 1. Ogni barra nei grafici dell’istogramma rappresenta la frequenza media normalizzata al numero totale di ingressi della porta di ricompensa ±SEM.DOI:http://dx.doi.org/10.7554/eLife.27483.01610.7554/eLife.27483.017FigureSupplemento a 5 cifre 1.Numero totale di voci del porto di ricompensa e cambiamenti nelle variazioni dei tempi di attesa nelle varie fasi dell’attività. In ogni prova durante tutte le condizioni di base in cui il valore complessivo delle opzioni BT e AT erano equivalenti, le voci del porto di ricompensa sono state registrate in contenitori da 1 s durante il periodo di attesa.(A) Tutti i gruppi di animali sono stati abbinati nel numero totale di entrate del porto di ricompensa (p=0,636).(B) Abbiamo anche considerato i cambiamenti nei tempi di attesa durante il nostro compito. Abbiamo calcolato la variazione dei tempi di entrata nel porto di ricompensa durante ogni linea di base (fase iniziale del compito e quattro linee di base che separano i turni) separatamente per ogni animale. C’è stato un effetto principale significativo del gruppo di lesioni sulle variazioni dei tempi di attesa per l’opzione HV (p<0,0001) con animali con lesioni OFC che hanno dimostrato una variabilità costantemente inferiore nel loro comportamento di attesa, nonostante l’esperienza con i turni. I dati sono mostrati come mezzi di gruppo ± SEM, **p<0.01.DOI:http://dx.doi.org/10.7554/eLife.27483.017

Abbiamo anche considerato i cambiamenti nei tempi di attesa in tutto il nostro compito. Abbiamo calcolato la variazione dei tempi di ingresso al porto di ricompensa durante ogni linea di base (fase iniziale del compito e quattro linee di base che separano i turni) per ogni animale. Abbiamo poi sottoposto le varianze stimate alle ANOVA con ordine di base (dal 1 ° al 5 °) come all’interno del gruppo di lesioni e come fattori tra i soggetti. Analogamente alla nostra precedente analisi delle linee di base combinate, non abbiamo rilevato alcuna differenza di gruppo nei tempi di attesa per l’opzione LV (tutti i valori p>0,2). Tuttavia, c’è stato un effetto principale significativo del gruppo di lesioni sulle variazioni dei tempi di attesa per l’opzione HV [F(2,21)=117.074, p<0.0001; Figura 5-figure supplement 1] con animali con lesioni OFC che dimostrano una variabilità costantemente inferiore nel loro comportamento di attesa, nonostante l’esperienza con i turni. È importante notare che, poiché le nostre analisi includevano solo il tempo di attesa prima della consegna del premio, questi risultati suggeriscono che gli animali colonizzati da OFC mantengono la capacità di formare semplici aspettative di risultato basate su un’esperienza a lungo termine, ma la loro capacità di rappresentare le distribuzioni di risultato più complesse è compromessa.

Figura 5-figure supplement 1.Gli animali con lesioni ventrali da OFC non riescono a rappresentare l’incertezza prevista nei ritardi di ricompensa.Abbiamo valutato se le lesioni BLA e le lesioni ventrali OFC alterano la capacità degli animali di formare aspettative sui tempi di consegna dei premi. In ogni prova durante tutte le condizioni di base in cui il valore complessivo delle opzioni BLA e HV era equivalente, le entrate del porto di ricompensa sono state registrate in contenitori da 1 s durante il periodo di attesa. Non ci sono state differenze significative nelle modalità dei tempi di consegna dei premi previsti per i vari gruppi (p=0,394). Allo stesso modo, i gruppi sono stati uguagliati nel numero totale di entrate del porto a pagamento (p=0,636), come mostrato nella figura 5-figure supplement 1. Mentre le distribuzioni dei tempi di ricerca dei premi negli animali con lesioni BLA erano indistinguibili da quelle degli animali di controllo e dai ritardi reali (A-F), gli animalicon lesioni OFC hanno concentrato le loro registrazioni dei porti di ricompensa nell’intervallo di tempo corrispondente ai ritardi medi (G,H), suggerendo che mentre questi animali possono dedurre il risultato medio, non riescono a rappresentare la varianza (cioè l’incertezza attesa). Abbiamo anche considerato le variazioni dei tempi di attesa nel corso del nostro compito; questi dati sono mostrati nella Figura 5-figure supplement 1. Ogni barra nei grafici dell’istogramma rappresenta la frequenza media normalizzata al numero totale di ingressi della porta di ricompensa ±SEM.DOI:

http://dx.doi.org/10.7554/eLife.27483.016In ogni prova, durante tutte le condizioni di base in cui il valore complessivo delle opzioni BT e AT era equivalente, le entrate dei porti a premio sono state registrate in contenitori da 1 s durante il periodo di attesa.(A) Tutti i gruppi di animali sono stati abbinati nel numero totale di entrate del porto di ricompensa (p=0,636).(B) Abbiamo anche considerato i cambiamenti nei tempi di attesa durante il nostro compito. Abbiamo calcolato la variazione dei tempi di entrata nel porto di ricompensa durante ogni linea di base (fase iniziale del compito e quattro linee di base che separano i turni) separatamente per ogni animale. C’è stato un effetto principale significativo del gruppo di lesioni sulle variazioni dei tempi di attesa per l’opzione HV (p<0,0001) con animali con lesioni OFC che hanno dimostrato una variabilità costantemente inferiore nel loro comportamento di attesa, nonostante l’esperienza con i turni. I dati sono mostrati come mezzi di gruppo ± SEM, **p<0,01.DOI:

http://dx.doi.org/10.7554/eLife.27483.017

Figura 5-figure supplement 1.Numero totale delle entrate del porto di ricompensa e delle variazioni dei tempi di attesa nelle varie fasi dell’attività.In ogni prova durante tutte le condizioni di base in cui il valore complessivo delle opzioni BT e AT erano equivalenti, le entrate dei porti di ricompensa sono state registrate in contenitori da 1 s durante il periodo di attesa.(A) Tutti i gruppi di animali sono stati abbinati nel numero totale di entrate del porto di ricompensa (p=0,636).(B) Abbiamo anche considerato i cambiamenti nei tempi di attesa durante il nostro compito. Abbiamo calcolato la variazione dei tempi di entrata nel porto di ricompensa durante ogni linea di base (fase iniziale del compito e quattro linee di base che separano i turni) separatamente per ogni animale. C’è stato un effetto principale significativo del gruppo di lesioni sulle variazioni dei tempi di attesa per l’opzione HV (p<0,0001) con animali con lesioni OFC che hanno dimostrato una variabilità costantemente inferiore nel loro comportamento di attesa, nonostante l’esperienza con i turni. I dati sono mostrati come mezzi di gruppo ± SEM, **p<0,01.DOI:

http://dx.doi.org/10.7554/eLife.27483.017

Le lesioni al BLA e all’OFC ventrale inducono un fenotipo che evita l’incertezza in condizioni di base

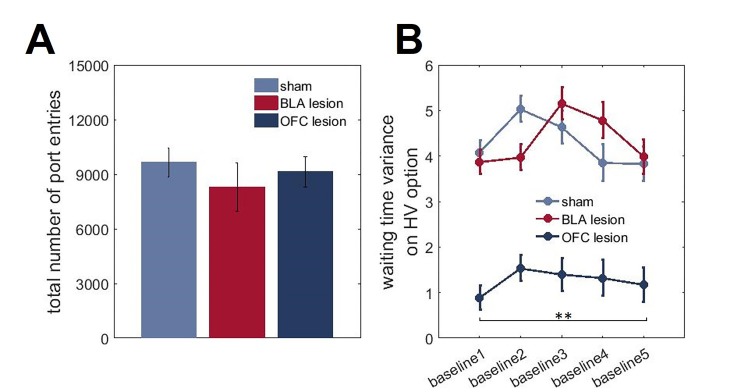

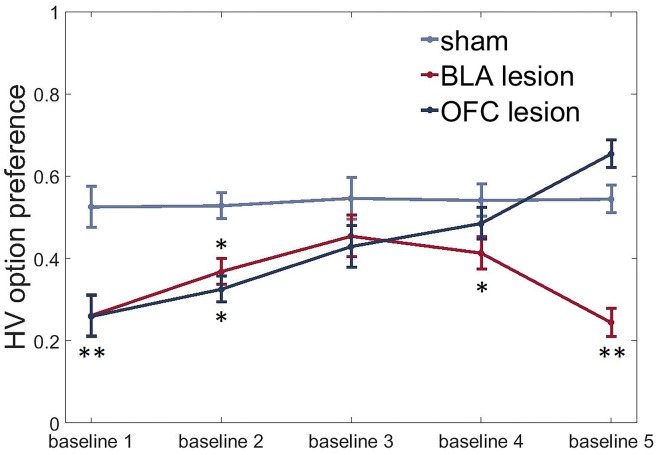

Per valutare le differenze di gruppo nella ricerca dell’incertezza o nell’evitare, abbiamo sottoposto i dati di preferenza dell’opzione HV in condizioni di base ad un ANOVA con il tempo (cinque test di base ripetuti che separano gli spostamenti di valore) come gruppo di appartenenza e di lesione come fattori tra i soggetti. Oltre ai loro effetti sull’apprendimento del valore, le lesioni sia al BLA che all’OFC ventrale hanno indotto un fenotipo evitante l’incertezza con animali in entrambi i gruppi sperimentali che hanno dimostrato una preferenza ridotta per l’opzione HV in condizioni di base rispetto al gruppo di controllo all’inizio del test [tempo x interazione del gruppo]: F(4.37,45.87) = 8.484, p<0.0001; post hoc sham vs BLA: p=0.002; sham vs OFC: p=0.002, Figura 6]. BLA-animali assediati hanno continuato ad evitare l’opzione incerta per tutta la durata del nostro esperimento (tutti i valori di p < 0,05, ad eccezione della valutazione di base tre quando questo gruppo non era diverso dagli animali di controllo). Tuttavia, gli animali con OFC hanno aumentato le loro scelte dell’opzione HV durante le condizioni di base con test ripetuti: erano indistinguibili dai controlli durante le linee di base 3 e 4 e hanno persino dimostrato una tendenza a una preferenza più elevata rispetto al gruppo di controllo durante l’ultima linea di base [test post hoc, OFC vs finto: p=0,059].10.7554/eLife.27483Abbiamo osservato una significativa riduzione della preferenza per l’opzione HV in condizioni di base in entrambi i gruppi sperimentali rispetto agli animali di controllo all’inizio dei test (sham vs BLA: p=0.002; sham vs OFC: p=0.002). Gli animali con BLA hanno continuato ad evitare l’opzione rischiosa per la maggior parte dell’esperimento (tutti i valori di p < 0,05, ad eccezione della valutazione della linea di base tre quando questo gruppo non era diverso dagli animali di controllo). Gli animali con OFC hanno progressivamente aumentato le loro scelte dell’opzione HV durante le condizioni di base con test ripetuti: erano indistinguibili dai controlli durante le linee di base 3 e 4 e hanno persino dimostrato una tendenza a una preferenza più elevata rispetto al gruppo di controllo durante l’ultima linea di base [test post hoc, OFC vs finto: p=0,059]. I dati sono mostrati come mezzi di gruppo per condizione ±SEM, *p<0.05, **p<0.01. Le statistiche di riepilogo e i dati individuali degli animali sono forniti nella figura 6-source data 1.DOI:http://dx.doi.org/10.7554/eLife.27483.01810.7554/eLife.27483.019Figure6-source data 1.Summary statistics and individual data for HV option preference following lesions.DOI:http://dx.doi.org/10.7554/eLife.27483.019

Figura 6 – Dati sorgente 1.Statistiche di riepilogo e dati individuali per la preferenza dell’opzione HV a seguito di lesioni.statistiche di riepilogo e dati individuali per la preferenza dell’opzione HV a seguito di lesioni.Abbiamo osservato una significativa riduzione della preferenza per l’opzione HV in condizioni di base in entrambi i gruppi sperimentali rispetto agli animali di controllo all’inizio del test (sham vs BLA: p=0,002; sham vs OFC: p=0,002). Gli animali con BLA hanno continuato ad evitare l’opzione rischiosa per la maggior parte dell’esperimento (tutti i valori di p < 0,05, ad eccezione della valutazione della linea di base tre quando questo gruppo non era diverso dagli animali di controllo). Gli animali con OFC hanno progressivamente aumentato le loro scelte dell’opzione HV durante le condizioni di base con test ripetuti: erano indistinguibili dai controlli durante le linee di base 3 e 4 e hanno persino dimostrato una tendenza a una preferenza più elevata rispetto al gruppo di controllo durante l’ultima linea di base [test post hoc, OFC vs finto: p=0,059]. I dati sono mostrati come mezzi di gruppo per condizione ±SEM, *p<0.05, **p<0.01. Le statistiche riassuntive e i dati dei singoli animali sono forniti nella Figura 6 – dati fonte 1.1. DOI:

http://dx.doi.org/10.7554/eLife.27483.01810.7554/eLife.27483.019Cifre dati a 6 fonti 1.Statistiche di sintesi e dati individuali per la preferenza dell’opzione HV in seguito a lesioni.DOI:http://dx.doi.org/10.7554/eLife.27483.019DOI:

http://dx.doi.org/10.7554/eLife.27483.019DOI:

http://dx.doi.org/10.7554/eLife.27483.019

Discussione