Abstract

Background

Il riconoscimento che gli studi sperimentali di efficacia da soli sono insufficienti per migliorare la salute pubblica[1] ha portato ad una rapida espansione dei campi di applicazione e di miglioramento delle scienze[2- 5]. Tuttavia, gli studi che mirano a identificare strategie che facilitino l’adozione, la sostenibilità e la scalabilità delle evidenze possono non tradursi bene all’interno dei tradizionali paradigmi di ricerca sull’efficacia e l’efficienza[6].

La necessità di nuovi strumenti per aiutare i ricercatori e gli stakeholder della ricerca nella scienza dell’implementazione è diventata chiara durante la valutazione delle sovvenzioni presentate all’Evans Center for Implementation and Improvement Sciences (CIIS) dell’Università di Boston. Il CIIS è stato istituito nel 2016 per promuovere il rigore scientifico in progetti nuovi e in corso volti ad aumentare l’uso delle prove e a migliorare i risultati dei pazienti all’interno di un centro medico urbano, accademico e di sicurezza. Come parte dell’obiettivo del CIIS di promuovere metodi rigorosi di implementazione e miglioramento, il CIIS ha stabilito un bando per la richiesta di sovvenzioni pilota per l’implementazione e il miglioramento delle scienze [7]. Le proposte sono state sottoposte a peer-reviewing utilizzando i tradizionali criteri di punteggio dei National Institutes of Health (NIH)[8]. Attraverso due cicli di domande di sovvenzione, i revisori delle proposte hanno identificato la necessità di migliorare i criteri di valutazione in grado di identificare specifici punti di forza e di debolezza per valutare l’impatto potenziale dei progetti di studio di implementazione e/o di miglioramento.

Descriviamo lo sviluppo e la valutazione di ImplemeNtation and Improvement Science Proposal Evaluation CriTeria (INSPECT): uno strumento per la valutazione standardizzata delle proposte di ricerca di implementazione e miglioramento. Lo strumento INSPECT cerca di rendere operativi i criteri proposti da Proctor et al. come “ingredienti chiave” che costituiscono una proposta scientifica di implementazione ben elaborata, che opera all’interno del quadro di valutazione delle proposte di NIH [6].

Metodi

Valutazione del bisogno

Nell’aprile del 2016 e nell’aprile del 2017 il CIIS ha pubblicato le richieste di richieste di sovvenzioni pilota incentrate sulle scienze dell’implementazione e del miglioramento[7]. La richiesta di domande descriveva l’opportunità per i ricercatori di ricevere fino a 15.000 dollari per la ricerca innovativa sulle scienze di implementazione e miglioramento su qualsiasi argomento relativo al miglioramento dei processi e dei risultati dell’erogazione dell’assistenza sanitaria in contesti di rete di sicurezza. Il CIIS finanzia sovvenzioni pilota con l’obiettivo di fornire ai ricercatori l’opportunità di ottenere dati preliminari per ulteriori ricerche. Le proposte dovevano includere una pagina di obiettivi specifici e un piano di ricerca di tre pagine strutturato nel tradizionale quadro NIH con sottotitoli per significato, innovazione, approccio, ambiente e team di ricerca. Il framework NIH è stato richiesto perché corrisponde alla struttura delle proposte di sovvenzione richiesta dal NIH. Sono stati richiesti un budget di studio e una giustificazione, così come gli schizzi biografici del team di ricerca, senza limiti di pagina. Il CIIS ha ricevuto 30 domande di sovvenzione pilota che coprono un’ampia gamma di aree di contenuto, come la cessazione del fumo, l’epatite C, il diabete, il cancro e la sindrome da astinenza neonatale.

Sei ricercatori con esperienza in scienze dell’implementazione e del miglioramento hanno svolto il ruolo di revisori delle sovvenzioni. Quattro revisori hanno assegnato un punteggio a ciascuna proposta. I revisori hanno valutato la qualità delle proposte di studio pilota, assegnando punteggi numerici da 1 a 9 (1 = eccezionale, 9 = scarso) per ciascuno dei criteri NIH (significato, innovazione, ricercatori, approccio, ambiente, impatto complessivo)[8]. Il CIIS ha scelto di utilizzare i criteri NIH per valutare le domande di sovvenzione pilota perché i criteri sono quelli utilizzati dai sistemi di peer review dei NIH per valutare il merito scientifico e tecnico delle proposte di sovvenzione. Il team di revisione delle sovvenzioni CIIS ha tenuto una “sezione di studio” per esaminare e discutere le proposte. Tuttavia, durante l’incontro, i revisori hanno fornito un feedback sul fatto che i criteri di valutazione dell’NIH, basati sul paradigma tradizionale della ricerca sull’efficacia e l’efficienza, non hanno offerto una guida sufficiente per valutare le proposte scientifiche di implementazione e miglioramento, né hanno fornito una sufficiente specificità per gli autori delle proposte che hanno meno esperienza nella ricerca sull’implementazione. I revisori delle sovvenzioni hanno richiesto nuovi criteri di valutazione delle proposte che informassero meglio le decisioni sui punteggi e il feedback ai redattori delle proposte su aspetti specifici della scienza dell’implementazione, compresa la misurazione della forza della progettazione dello studio di implementazione, della strategia, della fattibilità e della pertinenza.

Nonostante la difficoltà di utilizzare i tradizionali criteri di valutazione NIH, il comitato di revisione ha utilizzato tali criteri per assegnare un punteggio a tutte le sovvenzioni ricevute durante i primi 2 anni di richiesta di proposte. I finanziamenti per le sovvenzioni pilota CIIS sono stati assegnati alle domande che hanno ricevuto i punteggi più bassi (migliori) secondo i criteri NIH e hanno ricevuto un feedback positivo dal comitato di revisione.

La richiesta di criteri più espliciti di valutazione scientifica dell’implementazione ha spinto il team di ricerca CIIS a condurre una valutazione qualitativa delle esigenze di tutte le 30 domande di studio pilota, al fine di determinare come le proposte descrivono i progetti di studio, le strategie di implementazione e altri aspetti della ricerca proposta per l’implementazione e il miglioramento. Tre membri del team di ricerca CIIS (MLD, AJW, DB) hanno presentato proposte pilota a codice aperto per identificare le proprietà relative ai concetti fondamentali della scienza dell’implementazione o della ricerca sull’efficacia e l’efficienza[9]. Il team ha identificato nelle proposte temi comuni, tra cui l’enfasi sulle ipotesi di efficacia, la descrizione di interventi non testati e l’assenza di strategie di implementazione e di quadri concettuali. La costante mancanza di caratteristiche identificate come aspetti importanti della scienza dell’implementazione ha rafforzato la necessità di criteri che affrontino in modo specifico gli approcci della scienza dell’implementazione per guidare sia la preparazione delle proposte che la valutazione.

Criteri di valutazione operativa

Abbiamo identificato i “dieci ingredienti chiave” di Proctor et al. per la redazione di proposte di ricerca sull’implementazione [6] come un quadro appropriato per guidare e valutare le proposte. Abbiamo reso operativi gli “ingredienti” in un sistema di punteggio. Per costruire il sistema di punteggio, è stata creata una scala a quattro punti (0-3) per ogni elemento. In generale, un punteggio di 3 è stato dato per un elemento se tutti i criteri richiesti per l’elemento erano pienamente soddisfatti; un punteggio di 2 è stato dato se i criteri erano in qualche modo, ma non completamente affrontati; un punteggio di 1 è stato dato se l’ingrediente era menzionato ma non reso operativo nella proposta o collegato al resto dello studio; e un punteggio di 0 è stato dato se l’elemento non era affatto affrontato nella proposta. La Tabella 1 illustra il sistema di punteggio INSPECT per i 10 elementi, in cui le proposte ricevono un punteggio per ciascuno dei 10 ingredienti, per un punteggio cumulativo compreso tra 0 e 30.Tabella 1Implementazione e miglioramento della scienza Criteri di valutazione delle proposteCriteriaScore0123Il gap di cura o di qualità- Non viene definito alcun gap di cura/qualità; può essere presentato un problema, ma non viene descritto come un gap di qualità o di cura- Nessuna informazione o mancanza di chiarezza nelle informazioni citate circa il potenziale di miglioramento o l’impatto dell’implementazione proposta e/o dello studio scientifico di miglioramento – Lo studio scientifico di implementazione e/o miglioramento proposto non è collegato ad una rete di sicurezza – Il gap di cura/qualità non chiaramente definito è scarsamente supportato da dati di impostazione locale inappropriati/inadeguati/irrilevanti (i.e., prove di una revisione del grafico o altri dati preliminari) o citazioni dalla letteratura- Informazioni insufficienti sul potenziale di miglioramento o sull’impatto dello studio scientifico proposto per l’implementazione e/o il miglioramento- Lo studio scientifico proposto per l’implementazione e/o il miglioramento non è esplicitamente collegato ad una rete di sicurezza- La definizione di un gap di cura/qualità è supportata da dati locali (es, Informazioni adeguate sul potenziale di miglioramento, ma che trarrebbero beneficio da ulteriori specificazioni – Lo studio scientifico di implementazione e/o miglioramento proposto si collega ad un’impostazione della rete di sicurezza, ma potrebbe richiedere ulteriori chiarimenti – Il gap di qualità chiaramente definito è supportato da dati di impostazione locale (ad es, La proposta di implementazione e/o studio di miglioramento è chiaramente collegata ad un’impostazione della rete di sicurezza Il trattamento basato sull’evidenza da implementare – Non viene identificato alcun intervento basato sull’evidenza o informato sull’evidenza o la giustificazione dell’intervento/sfondo si basa su zero/non appropriato/non adeguato/non adeguato citazioni dalla letteratura- Mancanza di chiarezza sul perché l’intervento è stato scelto per l’impostazione dello studio- Non è chiaro quale effetto l’intervento avrà sull’impostazione della rete di sicurezza selezionata (o lo studio non è basato sull’impostazione della rete di sicurezza)- Alcuni testi sono citati per fornire l’evidenza di limitati studi di efficacia precedenti riguardanti l’intervento pianificato, che soddisfano i criteri di “evidence-informed” piuttosto che quelli di “evidence-based”- La limitata giustificazione del perché l’intervento è stato scelto per l’impostazione dello studio e/o la giustificazione si basa sul desiderio di documentare l’efficacia dell’intervento proposto – Informazioni insufficienti che descrivono l’effetto che l’intervento avrà sull’impostazione della rete di sicurezza selezionata – Viene citata una sufficiente letteratura che dimostra l’evidenza di studi di efficacia precedenti che utilizzano l’intervento per soddisfare i criteri “evidence-informed” o “evidence-based”. Se l’intervento è “evidence-informed”, l’uso innovativo di tale intervento nel setting dello studio è abbastanza convincente da essere considerato, o c’è una giustificazione appropriata sul perché l’intervento basato sull’evidenza è stato scelto per il setting dello studio, e l’obiettivo non è basato sullo sviluppo dell’efficacia di tale pratica basata sull’evidenza- Informazioni adeguate che descrivono l’effetto che l’intervento avrà sul setting della rete di sicurezza selezionato, ma potrebbero richiedere ulteriori chiarimenti- Chiaramente discute l’evidenza di studi di efficacia precedenti riguardanti l’intervento pianificato, rispondendo a criteri “evidence-based” piuttosto che “evidence-informed” – Motivazione esplicita e ben ponderata per l’implementazione dell’intervento nel setting di rete di sicurezza selezionato, incluso il potenziale effetto che esso avrà su quel setting – Modello concettuale e giustificazione teorica – Non viene discusso alcun modello concettuale, quadro di riferimento, o altro fondamento teorico -. Viene citato un modello concettuale, ma le sue basi e i suoi costrutti sono irrilevanti per gli obiettivi di studio e/o per l’impostazione dello studio- Vengono menzionati un modello concettuale, un quadro di riferimento o altri fondamenti teorici, ma non sono collegati agli obiettivi di studio, alle ipotesi e alle misure- Il modello concettuale, il quadro di riferimento o altri fondamenti teorici scelti possono essere appropriati per l’intervento, ma il razionale non è chiaramente supportato da citazioni dalla letteratura- Un modello concettuale, un quadro di riferimento o altre basi teoriche sono collegati in qualche modo agli obiettivi di studio, alle ipotesi e alle misure, ma potrebbero richiedere ulteriori chiarimenti – Il modello concettuale, il quadro di riferimento o altre basi teoriche scelte sono appropriate per le strategie di intervento/attuazione, come evidenziato da una logica ben definita con adeguate citazioni dalla letteratura, ma potrebbero comunque beneficiare di ulteriori specificità -. Un modello concettuale o quadro concettuale specifico per l’implementazione e/o il miglioramento è chiaramente descritto, con costruzioni teoriche esplicitamente descritte all’interno del contesto proposto, della popolazione e dei contesti di intervento – Il modello concettuale o quadro concettuale specifico per l’implementazione e/o il miglioramento è usato per inquadrare lo studio proposto in tutti gli aspetti, incluse le domande dello studio, gli obiettivi/obiettivi, le ipotesi, il processo e le misure di risultato -. Alcune discussioni possono fare riferimento e descrivere come i risultati dello studio si baserebbero o contribuirebbero in altro modo alla teoria o ai più ampi campi della scienza dell’implementazione e/o del miglioramentoPriorità degli stakeholder, impegno nel cambiamento – Zero o descrizione estremamente limitata di chi sono gli stakeholder o quali sono le loro preferenze e priorità intorno all’intervento proposto – Nessuna prova della pianificazione dell’analisi degli stakeholder o della raccolta di informazioni di base viene discussa in relazione a come il richiedente ha sviluppato le strategie di implementazione – Descrizione limitata di chi sono gli stakeholder, con alcuni attori chiave che mancano di considerazione – La comprensione limitata delle priorità degli stakeholder e delle preoccupazioni relative all’intervento è dimostrata da potenziali questioni facilmente identificabili che non sono discusse nella domanda, o non viene discussa alcuna prova della pianificazione dell’analisi degli stakeholder -. Nessuna o pochissima menzione del coinvolgimento degli stakeholder nella progettazione concettuale dell’intervento, e/o considerazione delle strategie di implementazione, del processo, o dei risultati- Nessun chiaro accordo o collaborazione tra gli stakeholder e il richiedente è spiegato- Sufficiente descrizione di chi sono tutti gli stakeholder identificabili- Chiara comprensione delle preoccupazioni delle parti interessate relative all’intervento, come evidenziato da un piano di analisi delle parti interessate che descrive come il richiedente raccoglierà almeno alcune informazioni sugli interessi delle parti interessate, le interrelazioni, le influenze, le preferenze, e/o le priorità- Una descrizione poco chiara di come le parti interessate sono state coinvolte nella progettazione concettuale dell’intervento, e/o considerazione delle strategie di implementazione, del processo, o degli esiti- Un qualche tipo di accordo o collaborazione tra le parti interessate e il richiedente è spiegato, ma le prove a sostegno sono limitate- Descrizione completa di chi sono tutti gli stakeholder identificabili – Chiara comprensione delle preoccupazioni degli stakeholder relative all’intervento, come evidenziato da un piano di analisi degli stakeholder che descrive come il richiedente raccoglierà informazioni complete sugli interessi degli stakeholder, le interrelazioni, le influenze, le preferenze e le priorità – Descrizione dettagliata di come gli stakeholder sono stati coinvolti nella progettazione concettuale dell’intervento e nella considerazione delle strategie di implementazione, del processo e degli esiti- Un accordo esplicito (come un memorandum d’intesa) o una prova di collaborazione tra gli stakeholder e il richiedente che viene spiegato con rilevanza per il processo di studio proposto e come i risultati saranno comunicati. Nessuna informazione sulla capacità del setting di studio o sulla preparazione per l’implementazione – Nessuna informazione su come coloro che nel setting di studio si oppongono al cambiamento saranno coinvolti o avranno le loro preoccupazioni affrontate dai processi o componenti dello studio – Qualche descrizione dell’interesse del setting per l’intervento proposto- Descrizione incompleta o poco chiara di come il setting sarà valutato per quanto riguarda la capacità e/o la disponibilità all’implementazione, inclusi i metodi e gli strumenti che saranno utilizzati, o c’è una descrizione limitata della cultura organizzativa/politica e delle potenziali barriere o facilitatori contestuali – Può includere una breve discussione su come coloro che si oppongono al cambiamento nel setting di studio saranno coinvolti o le loro preoccupazioni saranno affrontate dai processi di studio o dai componenti – Non può includere prove di supporto (e.g., lettere) del setting di studio che affrontano come lo studio proposto si allinea con le priorità/politiche dell’organizzazione – Descrive chiaramente l’interesse del setting e le motivazioni dell’intervento proposto – Descrive chiaramente come il setting sarà valutato per la capacità e la prontezza per l’implementazione, inclusi i metodi, le scale o altri strumenti che saranno utilizzati – Descrive accuratamente la potenziale influenza della cultura organizzativa/politica, e le potenziali barriere contestuali o facilitatori – Può includere strategie per come coloro che si oppongono al cambiamento nel setting dello studio saranno coinvolti o avranno le loro preoccupazioni affrontate dai processi o componenti dello studio – Non può includere prove di supporto (e.g., lettere) dal contesto dello studio che affrontano il modo in cui lo studio proposto si allinea con le priorità/politiche dell’organizzazione – Descrive esplicitamente i dati preliminari sulla capacità organizzativa e politica valutata e sulla preparazione per l’implementazione (valutazione completata prima dell’applicazione/pilota)-. Le valutazioni preliminari della capacità e della prontezza sono state completate utilizzando una scala con validità e affidabilità stabilite, o una scala che è stata sottoposta ad un certo test di validità e affidabilità – Può includere strategie per come coloro che si oppongono al cambiamento nell’impostazione dello studio saranno coinvolti o avranno le loro preoccupazioni affrontate dai processi o componenti dello studio – Evidenza di supporto (e.g., lettere) dall’impostazione dello studio che riguardano il modo in cui lo studio proposto si allinea alle priorità/politiche dell’organizzazione Strategia di attuazione/processi di attuazione – Non vengono identificate strategie di attuazione – L’intervento può essere erroneamente descritto come una strategia di attuazione – Le strategie di attuazione non sono chiaramente distinte dall’intervento – Strategie di attuazione non chiare non sono teoricamente giustificate e/o non corrispondono agli obiettivi dichiarati/impostazioni /misure di risultato dello studio proposto – Descrizione limitata che collega le strategie di implementazione agli obiettivi dichiarati/misure di impostazione/misure di risultato dello studio proposto senza un piano su come le strategie saranno osservate o testate – Le strategie di implementazione possono essere irrealistiche date le tempistiche pilota e/o i vincoli di budget – Le strategie di implementazione sono chiaramente distinte dall’intervento – Qualche giustificazione teorica delle strategie di implementazione – Descrive chiaramente come le strategie di implementazione si collegano agli obiettivi dichiarati/le misure di impostazione/misure di risultato dello studio proposto- È necessaria una descrizione più dettagliata per capire chiaramente come le strategie di implementazione saranno osservate o testate empiricamente- Le strategie di implementazione sono per lo più fattibili data la tempistica dello studio pilota e i vincoli di budget- Descrive esplicitamente e giustifica teoricamente le strategie di implementazione- Descrive esplicitamente come le strategie di implementazione si collegano agli obiettivi dichiarati/le misure di impostazione/misure di risultato dello studio proposto- Descrive esplicitamente come le strategie di implementazione saranno osservate o testate empiricamente – Le strategie di implementazione sono fattibili date le tempistiche dello studio pilota e i vincoli di budget L’esperienza del team con l’impostazione, il trattamento e il processo di implementazione – Sono descritte solo le competenze dell’investigatore principale- Non sono fornite informazioni aggiuntive, schizzi biografici, curriculum vitae e CV al di là dell’investigatore principale- Non è chiaro in che modo l’esperienza del team sia in relazione con l’impostazione dello studio, il trattamento e/o i processi – Il piano del personale potrebbe non facilitare il completamento dello studio senza un significativo supporto da parte del CIIS – L’esperienza del team è uniforme e non offre competenze multidisciplinari o una prospettiva multidisciplinare allo studio proposto – La descrizione del team, gli schizzi biografici, i curriculum vitae e i CV descrivono un insieme di competenze multidisciplinari rilevanti per l’impostazione dello studio proposto, il trattamento, i processi e altre necessità – Il piano del personale facilita il completamento dello studio, con un certo supporto da parte del CIIS probabilmente necessario – Nessuna descrizione dei punti di forza dell’ambiente di ricerca, comprese le risorse e/o le infrastrutture – Se il ricercatore principale è considerato un giovane o all’inizio della carriera o un principiante nella scienza dell’implementazione, non è chiaro quale dirigente senior al di fuori del CIIS sarà disponibile per il tutoraggio e/o la consulenza – Descrive chiaramente come l’esperienza del team è in relazione con l’impostazione dello studio, il trattamento e i processi – Descrizione del team, schizzi biografici, curriculum vitae e CV descrivono un insieme di competenze multidisciplinari rilevanti per l’impostazione dello studio proposto, il trattamento, i processi e altre necessità- Il piano del personale facilita il completamento dello studio senza richiedere il supporto del CIIS- Descrive chiaramente i punti di forza dell’ambiente di ricerca, comprese le risorse e le infrastrutture- Se il ricercatore principale è considerato un giovane o all’inizio della carriera o un principiante nella scienza dell’implementazione, è stata identificata una leadership senior al di fuori del CIIS per supportare il completamento dello studio con il tutoraggio e/o la consulenza-Fattibilità del progetto e dei metodi di ricerca proposti- Lo studio proposto include metodi, interventi e altre componenti che esulano dall’ambito di uno studio pilota e/o sono inappropriati per uno studio pilota – Un budget e/o una tempistica non sono inclusi o non sono realistici – Le potenziali barriere all’implementazione non sono descritte o sono insormontabili – Lo studio proposto include metodi, interventi e altre componenti che possono essere difficili da realizzare – Il budget e/o la tempistica non sono inclusi o sono irrealistici- Le potenziali barriere all’implementazione non sono chiaramente descritte o sono insormontabili- Lo studio proposto include metodi, interventi e altre componenti appropriate che sono probabilmente realizzabili come studio pilota- Il budget e/o la tempistica potrebbero richiedere una revisione- Le potenziali barriere all’implementazione sono chiaramente descritte ma potrebbero mancare una chiara descrizione di come tali barriere saranno superate- Lo studio proposto include metodi, interventi e altri componenti appropriati che sono realizzabili come studio pilota e che sono giustificati rispetto a potenziali alternative – Il budget e la tempistica sono appropriati – Le potenziali barriere all’implementazione sono chiaramente identificate con i potenziali piani per superare tali barriere – La sezione di misurazione e analisi – I risultati descritti non sono legati all’implementazione o al miglioramento scientifico – I risultati non sono collegati agli obiettivi dello studio proposto – L’unità di analisi non è appropriata per lo studio proposto- Non sono inclusi piani di misurazione e/o di analisi dei dati per descrivere come saranno misurati le variabili e i risultati- I risultati descritti sono relativi all’implementazione e/o al miglioramento scientifico- I risultati non sono chiaramente collegati agli obiettivi dello studio proposto- L’unità di analisi è appropriata per lo studio proposto- I piani di misurazione e/o di analisi dei dati non descrivono chiaramente come saranno misurati tutte le variabili e i risultati, o i piani non sono appropriati per lo studio proposto- I risultati descritti sono relativi all’implementazione e/o al miglioramento scientifico- I risultati sono chiaramente collegati agli obiettivi dello studio proposto- L’unità di analisi è appropriata per lo studio proposto- I piani di misurazione e/o di analisi dei dati descrivono come tutte le variabili e i risultati saranno misurati e sono appropriati per lo studio proposto, ma il collegamento al modello teorico non è chiaro- I risultati descritti sono relativi all’implementazione e/o al miglioramento della scienza – I risultati sono chiaramente collegati agli obiettivi dello studio proposto – L’unità di analisi è appropriata per lo studio proposto – I piani di misurazione e di analisi dei dati descrivono in modo robusto come tutte le variabili e i risultati saranno misurati e sono appropriati per lo studio proposto attraverso una chiara giustificazione teorica – Politiche/ambiente di finanziamento; leva del supporto per sostenere il cambiamento Non è incluso alcun riconoscimento delle tendenze politiche interne/esterne e/o dell’ambiente di finanziamento per lo studio proposto – Non è inclusa una discussione limitata o nulla dell’impatto potenziale dell’intervento – Non è inclusa una discussione limitata o nulla della diffusione dei risultati dello studio – Le tendenze politiche interne/esterne e/o l’ambiente di finanziamento sono discusse, ma sono necessari ulteriori chiarimenti – L’impatto potenziale dell’intervento non è legato al contesto politico e/o di finanziamento e potrebbe non essere rilevante per una rete di sicurezza – Il piano di divulgazione dei risultati dello studio non indica chiaramente che verrà dato un contributo al più ampio livello di politica e alla creazione di una rete di sicurezza – Le tendenze politiche interne/esterne e/o l’ambiente di finanziamento sono chiaramente descritti – Il potenziale impatto dell’intervento è collegato alle politiche rilevanti e alle questioni di finanziamento associate alla creazione di una rete di sicurezza, ma potrebbe essere necessario un ulteriore chiarimento – Il piano di divulgazione dei risultati dello studio indica che verrà dato un contributo al livello politico più ampio e alla creazione di una rete di sicurezza, ma non è chiaro quale contributo e come sarà realizzato- Le tendenze politiche interne/esterne e/o l’ambiente di finanziamento sono chiaramente descritti- Il potenziale impatto dell’intervento è esplicitamente collegato alle politiche rilevanti e alle questioni di finanziamento associate alla creazione di una rete di sicurezza- Il piano di divulgazione dei risultati dello studio indica che cosa e come verrà dato un contributo al livello politico più ampio e alla creazione di una rete di sicurezza

Test INSPETTO

Abbiamo utilizzato le proposte di studio pilota presentate al CIIS per sviluppare e valutare l’utilità e l’affidabilità del sistema di punteggio INSPECT. Inizialmente, due membri del team di ricerca (ELC, DB) hanno applicato in modo indipendente i criteri dei 10 elementi a 7 delle 30 proposte di sovvenzione pilota. Quattro membri del team (MLD, AJW, ELC, DB) si sono poi riuniti per discutere questi risultati iniziali e raggiungere un consenso sui criteri di punteggio. Due membri del team (ELC, DB) hanno poi assegnato un punteggio indipendente alle restanti 23 domande di studio pilota utilizzando il sistema di punteggio rivisto. Entrambi i revisori hanno registrato brevi giustificazioni per ciascuno dei dieci punteggi assegnati alle singole proposte di studio. I due codificatori (ELC, DB) si sono poi riuniti per confrontare i punteggi, condividere le giustificazioni dei punteggi e determinare i punteggi finali specifici per ogni proposta utilizzando il consenso del gruppo.

L’affidabilità inter-coder con il protocollo di punteggio è stata misurata utilizzando l’alfa di Krippendorff per valutare il disaccordo osservato e previsto tra i punteggi iniziali dei due codificatori [10, 11]. Un coefficiente alfa di 0,70 è stato considerato a priori come il più basso livello accettabile di accordo per stabilire l’affidabilità del nuovo protocollo di punteggio[10, 11]. Sono state condotte analisi di frequenza per determinare la distribuzione dei punteggi finali specifici per elemento (0-3) in tutte le proposte. Abbiamo calcolato un coefficiente di correlazione per valutare l’associazione tra i punteggi delle proposte assegnate utilizzando il framework NIH e i punteggi assegnati utilizzando INSPECT. Tutti i calcoli sono stati eseguiti nella versione R 3.3.2[12].

Risultati

La revisione iterativa delle 30 proposte di ricerca utilizzando i “dieci ingredienti chiave” di Proctor et al. ha portato allo sviluppo e alla sperimentazione del sistema INSPECT per la valutazione delle proposte scientifiche di implementazione e miglioramento.

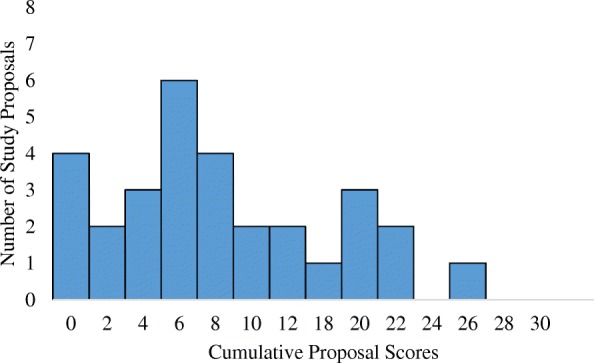

La Figura 1 mostra la giusta distribuzione perpendicolare dei punteggi cumulativi delle proposte, con la maggior parte delle proposte che ricevono bassi punteggi complessivi. Su un possibile punteggio cumulativo di 30, le proposte hanno avuto un punteggio mediano di 7 (IQR 3.3-11.8).Fig. 1Distribuzione dei punteggi cumulativi delle proposte assegnate usando ImplemeNtation and Improvement Science Proposal Evaluation CriTeria (INSPECT)

La tabella 2 presenta la distribuzione dei punteggi cumulativi e specifici per voce assegnati alle proposte secondo i criteri di INSPECT. Tra i singoli elementi, le proposte hanno ottenuto il punteggio più alto per i criteri che descrivono le lacune di cura/qualità nei servizi sanitari. Il 36 per cento delle proposte ha ricevuto il punteggio massimo di 3 per il soddisfacimento di tutti i requisiti relativi all’assistenza o alle cure o agli elementi di gap di qualità, incluso l’utilizzo di dati locali a sostegno dell’esistenza di un gap, inclusa una descrizione esplicita del potenziale di miglioramento, e il collegamento della ricerca proposta alle priorità di finanziamento (ad es, Tabella 2D distribuzione dei Punteggi di Implementazione e Miglioramento della Scienza della Valutazione delle Proposte CriTeria (INSPECT) Punteggi cumulativi delle Proposte Proposte valutate: n=30, Punteggio mediano 7 (IQR 3.3-11.8) Punteggi delle singole vociPunteggi delle singole vociPunteggi della scala di valutazione Alpha0123 (N = 150)(N = 74)(N = 47)(N = 29)(0.88)Il divario di cura o divario di qualità7 (23%)6 (20%)6 (20%)6 (20%)11 (36%)0,84Il trattamento basato sull’evidenza da attuare15 (50%)9 (30%)2 (7%)4 (13%)0,77Modello concettuale e giustificazione teorica21 (70%)4 (13%)3 (10%)2 (7%)0.99Priorità delle parti interessate, impegno nel cambiamento13 (43%)9 (30%)7 (23%)1 (3%)0,88Pronto ad adottare nuovi servizi/trattamenti/programmi16 (53%)7 (23%)6 (20%)1 (3%)0.96Strategia/processo di attuazione20 (67%)7 (23%)1 (3%)2 (7%)0,84esperienza del team in materia di impostazione, trattamento e processo di attuazione13 (43%)5 (17%)8 (27%)4 (13%)0.96Fattibilità della progettazione e dei metodi di ricerca proposti13 (43%)11 (37%)6 (20%)0 (0%)0,84Misurazione e analisi21 (70%)4 (13%)3 (10%)2 (7%)0,78Politica/ambiente di finanziamento; leva o sostegno per sostenere il cambiamento11 (37%)12 (40%)5 (17%)2 (7%)0,77

In generale, le proposte hanno ottenuto un punteggio mediocre per altri criteri. Come mostrato nella Tabella 2, la maggior parte delle proposte di studio ha ricevuto punteggi pari a 0 nelle categorie di trattamento basato sull’evidenza da attuare (50%), modello concettuale e giustificazione teorica (70%), disponibilità ad adottare nuovi servizi/trattamenti/programmi (53%), strategia/processo di attuazione (67%) e misurazione e analisi (70%). Per esempio, i revisori hanno dato punteggi pari a 0 per l’elemento “intervento basato sull’evidenza da implementare”, perché l’intervento non era basato sull’evidenza e il progetto ha cercato di stabilire l’efficacia, piuttosto che esaminare l’adozione di una prassi consolidata basata sull’evidenza. Allo stesso modo, le proposte che cercavano solo di studiare l’efficacia e non valutavano i risultati dell’implementazione[13] (ad esempio, adozione, fedeltà) hanno ricevuto punteggi pari a 0 per “misurazione e analisi”. Nessuna delle proposte di studio che miravano principalmente a valutare i risultati dell’efficacia esprimeva il duplice intento di ricerca di un progetto ibrido. Punteggi di 0 per le altre categorie sono stati dati quando le applicazioni mancavano di qualsiasi descrizione rilevante per la categoria, come ad esempio nessun modello concettuale, nessuna strategia di implementazione, o nessuna competenza del team di ricerca revenant per l’implementazione o il miglioramento della scienza.

La tabella 2 mostra i tassi valutati di affidabilità inter-codice nell’applicazione di INSPECT alle 30 proposte di studio pilota. Tra i codificatori è stato osservato un coefficiente alfa complessivo di 0,88. I tassi di affidabilità degli intercoder nell’applicazione di ciascuno dei 10 elementi alle proposte variavano da 0,77 a 0,99, tutti al di sopra della soglia di affidabilità di 0,70.

Inoltre, abbiamo osservato una moderata correlazione inversa(r=-0,62, p<0,01) tra i punteggi della proposta inizialmente assegnati utilizzando il framework NIH e i punteggi assegnati utilizzando INSPECT.

Fig. 1.Fig. 1. Distribuzione dei punteggi cumulativi delle proposte assegnate con l’ausilio di ImplemeNtation and Improvement Science Proposal Evaluation CriTeria (INSPECT)

Discussione

Abbiamo sviluppato un sistema affidabile di punteggio delle proposte che rende operativi i “dieci ingredienti chiave” di Proctor et al. per la stesura di una borsa di ricerca per l’implementazione [6]. La ricerca precedente che analizzava i processi di assegnazione delle sovvenzioni peer-review ha evidenziato la necessità di migliorare l’accordo di punteggio tra i peer reviewer[14]. Elevati livelli di disaccordo nell’interpretazione dei criteri di assegnazione delle sovvenzioni da parte dei valutatori portano a processi di peer-review inaffidabili e a decisioni di finanziamento basate più sul caso che sul merito scientifico [14]. I tassi di misurazione dell’affidabilità inter-rater sono un approccio standard per valutare l’utilità dei criteri di punteggio delle proposte esistenti e per valutare gli sforzi per migliorare i criteri[15, 16]. L’applicazione del sistema INSPECT ha dimostrato un’elevata affidabilità inter-rater nel complesso e all’interno di ciascuna delle 10 voci. L’alto grado di affidabilità misurato per INSPECT può essere correlato alla specificità del suo progetto come criterio di punteggio per l’implementazione e il miglioramento della scienza. Una revisione delle rubriche di punteggio riportate nella letteratura scientifica suggerisce che criteri focalizzati sul tema contribuiscono ad aumentare l’affidabilità del punteggio[17]. Inoltre, la moderata correlazione tra i punteggi assegnati utilizzando il framework NIH e i punteggi assegnati utilizzando INSPECT suggerisce la validità dei criteri INSPECT nella valutazione della qualità della proposta. I “dieci ingredienti chiave” di Proctor et al. per gli autori di sovvenzioni sono stati sviluppati per mappare i criteri NIH esistenti. La nostra versione operazionalizzata degli ingredienti come criteri di punteggio ha dimostrato che le proposte che hanno ottenuto un punteggio mediocre secondo i criteri NIH hanno ottenuto un punteggio mediocre anche secondo INSPECT.

L’applicazione del sistema INSPECT alle proposte di implementazione e di miglioramento della ricerca scientifica presso un centro medico accademico ha migliorato la capacità dei revisori delle proposte di identificare punti di forza e di debolezza specifici nell’approccio di implementazione. Nel complesso, le proposte hanno ricevuto punteggi elevati solo per l’identificazione del gap di assistenza o del gap di qualità. Poiché la ricerca sull’efficacia e sull’implementazione o sul miglioramento può utilizzare tecniche simili per stabilire il significato delle domande dello studio[18], le proposte possono ottenere un buon punteggio nella descrizione del gap di qualità, anche se in seguito hanno descritto ipotesi di efficacia che hanno ricevuto punteggi complessivamente bassi dal sistema INSPECT. Ulteriori studi dovrebbero esplorare le tecniche per descrivere le lacune di cura e di qualità che evidenziano le domande di ricerca sull’implementazione o sul miglioramento.

Punteggi costantemente bassi in quattro aree – definire il trattamento basato sull’evidenza da implementare, il modello concettuale e la giustificazione teorica, la disponibilità ad adottare nuovi programmi, la misurazione e l’analisi – suggeriscono che molti ricercatori che cercano di condurre una ricerca sull’implementazione possono avere idee sbagliate sugli obiettivi fondamentali di questo campo. Un’idea sbagliata può essere legata ad un’unica attenzione alla valutazione dell’efficacia di un intervento piuttosto che allo studio dei processi e dei risultati delle strategie di implementazione. La maggior parte delle proposte di studio valutate utilizzando INSPECT non mirava a migliorare l’adozione di qualsiasi pratica basata sull’evidenza, né includeva misure di implementazione quali l’accettabilità, l’adozione, la fattibilità, la fedeltà, la penetrazione o la sostenibilità[19]. Descrizioni inadeguate e incoerenti delle strategie di implementazione e dei risultati rappresentano una sfida importante per il successo complessivo dello studio di implementazione[20]. Oltre alle linee guida fornite dai criteri di INSPECT, i recenti sforzi per sviluppare standard di reporting degli studi di implementazione[21] possono aiutare gli autori delle proposte a descrivere la ricerca pianificata.

Diverse proposte riguardavano trattamenti o pratiche con scarsa evidenza del potenziale di miglioramento dell’assistenza sanitaria. Sebbene gli studi ibridi, che studiano sia l’efficacia che i risultati dell’implementazione, siano approcci pratici per stabilire l’efficacia delle pratiche informate sulle evidenze, misurando al contempo gli sforzi di implementazione[18], nessuna delle proposte di studio ha espresso questo duplice intento di ricerca o è stata concepita come progetti ibridi.

I nostri risultati suggeriscono anche una scarsa familiarità e un basso utilizzo di risorse per valutare la forza dell’evidenza (come il sistema di classificazione della qualità dell’evidenza e della forza delle raccomandazioni[22] e la scala di classificazione della tassonomia delle raccomandazioni[23]) per la ricerca sulla scienza dell’implementazione. Una valutazione più sistematica della forza dell’evidenza[24-27] necessaria per giustificare gli sforzi di implementazione può aiutare a differenziare la scienza dell’implementazione dalla ricerca sull’efficacia o sull’efficienza e a migliorare la comprensione dell’offerta di studi ibridi di utilità [28].

Ampliare l’accesso alla formazione in scienze dell’implementazione nelle università come parte del curriculum di ricerca dei servizi sanitari di base e migliorare l’accesso alle opportunità di sviluppo professionale che si concentrano sulle competenze concettuali e metodologiche di implementazione in modo agnostico in termini di contenuto aiuterebbe a costruire la capacità per la prossima generazione di ricercatori di scienze dell’implementazione. Inoltre, i programmi di formazione offrono l’opportunità di fornire una guida sia per la scrittura che per la valutazione della qualità delle domande di sovvenzione per le scienze dell’implementazione.

I punti di forza dei nostri risultati includono l’applicazione di INSPECT alle proposte di studio presentate da ricercatori con un’ampia gamma di esperienze specifiche di implementazione e miglioramento della scienza e che coprono una varietà di aree di contenuto. Tuttavia, i nostri risultati sono limitati in quanto caratterizzano la familiarità di un’istituzione accademica con la ricerca scientifica di implementazione e miglioramento e il sistema INSPECT richiede la convalida in altri contesti e su una più ampia gamma di valutazioni delle proposte. Inoltre, abbiamo misurato un alto grado di affidabilità inter-rater per INSPECT quando è stato applicato a un campione di proposte a basso punteggio. L’affidabilità inter-rater di INSPECT può diminuire quando viene applicata a un campione di proposte di qualità superiore, e i revisori sono tenuti a discriminare tra le gradazioni di qualità (cioè, punteggi da 1 a 3) piuttosto che per lo più dare un punteggio all’assenza di elementi chiave (cioè, punteggi da 0). La ricerca futura dovrebbe testare la validità di INSPECT confrontando i punteggi assegnati a INSPECT con le valutazioni assegnate alle proposte approvate dalla sezione di studio NIH Dissemination and Implementation Research in Health. La ricerca futura dovrebbe anche valutare la relazione tra le assegnazioni dei punteggi di INSPECT e il completamento con successo dello studio per determinare l’utilità di INSPECT come meccanismo per garantire la qualità e l’impatto della ricerca finanziata. Per aiutare in questi sforzi di ricerca prospettica, i prossimi inviti a presentare proposte da parte del CIIS utilizzeranno INSPECT come criterio di valutazione delle proposte.

Sebbene esistano diversi strumenti per aiutare i ricercatori a scrivere proposte di implementazione scientifica[6, 29, 30], esistono poche risorse per sostenere i revisori delle sovvenzioni. Questo studio ha identificato ulteriori funzionalità dei “dieci ingredienti chiave” di Proctor et al. come guida per gli scrittori, sviluppandoli in una lista di controllo dettagliata per i revisori delle proposte. La ricerca attuale dà un contributo sostanziale alle scienze dell’implementazione e del miglioramento, dimostrando l’utilità e l’affidabilità di un nuovo strumento progettato per aiutare i revisori delle sovvenzioni a identificare la ricerca di alta qualità.

Conclusione

In conclusione, abbiamo reso operativo un sistema di punteggio specifico per l’implementazione e il miglioramento della ricerca per fornire una guida per gli autori delle proposte e i revisori delle sovvenzioni. Abbiamo dimostrato l’utilità e l’affidabilità dei nuovi sistemi di punteggio INSPECT nel valutare la qualità della ricerca sulle scienze dell’implementazione e del miglioramento proposta in un centro medico accademico. La prevalenza di punteggi bassi nella maggior parte dei criteri di INSPECT suggerisce la necessità di promuovere la formazione sugli obiettivi della scienza dell’implementazione e del miglioramento, comprese le distinzioni concettuali e metodologiche dalla ricerca sull’efficacia e sull’efficienza.

References

- Glasgow RE, Lichtenstein E, Marcus AC. Why don’t we see more translation of health promotion research to practice? Rethinking the efficacy-to-effectiveness transition. Am J Public Health. 2003; 93:1261-1267. DOI | PubMed

- Neta G, Sanchez MA, Chambers DA, Phillips SM, Leyva B, Cynkin L. Implementation science in cancer prevention and control: a decade of grant funding by the National Cancer Institute and future directions. Implement Sci. 2015; 10:4. DOI | PubMed

- Purtle J, Peters R, Brownson RC. A review of policy dissemination and implementation research funded by the National Institutes of Health, 2007–2014. Implement Sci. 2015;11(1) 10.1186/s13012-015-0367-1.

- Tinkle M, Kimball R, Haozous EA, Shuster G, Meize-Grochowski R. Dissemination and implementation research funded by the US National Institutes of Health, 2005-2012. Nurs Res Pract. 2013; 2013:909606. PubMed

- Smits PA, Denis J-L. How research funding agencies support science integration into policy and practice: an international overview. Implement Sci. 2014; 9:28. DOI | PubMed

- Proctor EK, Powell BJ, Baumann AA, Hamilton AM, Santens RL. Writing implementation research grant proposals: ten key ingredients. Implement Sci. 2012; 7:96. DOI | PubMed

- . Accessed 2 Nov 2017.Publisher Full Text

- . Accessed 26 Oct 2017.Publisher Full Text

- Green J, Thorogood N. Qualitative methods for health research. 3rd ed. Thousand Oaks: SAGE Publications Ltd; 2013.

- Hayes AF, Krippendorff K. Answering the call for a standard reliability measure for coding data. Commun Methods Meas. 2007; 1:77-89. DOI

- Krippendorff K. Content analysis: an introduction to its methodology. SAGE Publications: Thousand Oaks, CA; 2004.

- R Core. R: a language and environment for statistical computing. 2016.

- Proctor E, Silmere H, Raghavan R, Hovmand P, Aarons G, Bunger A. Outcomes for implementation research: conceptual distinctions, measurement challenges, and research agenda. Admin Pol Ment Health. 2011; 38:65-76. DOI

- Marsh HW, Jayasinghe UW, Bond NW. Improving the peer-review process for grant applications: reliability, validity, bias, and generalizability. Am Psychol. 2008; 63:160-168. DOI | PubMed

- Sattler DN, McKnight PE, Naney L, Mathis R. Grant peer review: improving inter-rater reliability with training. PLoS One. 2015; 10:e0130450. DOI | PubMed

- Demicheli V, Di Pietrantonj C. Peer review for improving the quality of grant applications. Cochrane Database Syst Rev. 2007:MR000003. 10.1002/14651858.MR000003.pub2.

- Jonsson A, Svingby G. The use of scoring rubrics: reliability, validity and educational consequences. Educ Res Rev. 2007; 2:130-144. DOI

- Inouye SK, Fiellin DA. An evidence-based guide to writing grant proposals for clinical research. Ann Intern Med. 2005; 142:274-282. DOI | PubMed

- Proctor EK, Landsverk J, Aarons G, Chambers D, Glisson C, Mittman B. Implementation research in mental health services: an emerging science with conceptual, methodological, and training challenges. Adm Policy Ment Heal Ment Heal Serv Res. 2009; 36:24-34. DOI

- Proctor EK, Powell BJ, McMillen JC. Implementation strategies: recommendations for specifying and reporting. Implement Sci. 2013; 8:139. DOI | PubMed

- Pinnock H, Barwick M, Carpenter CR, Eldridge S, Grandes G, Griffiths CJ. Standards for reporting implementation studies (StaRI): explanation and elaboration document. BMJ Open. 2017; 7:e013318. DOI | PubMed

- Oxman AD. Grading quality of evidence and strength of recommendations. BMJ. 2004; 328:24-34. DOI | PubMed

- Ebell MH, Siwek J, Weiss BD, Woolf SH, Susman J, Ewigman B. Strength of recommendation taxonomy (SORT): a patient-centered approach to grading evidence in the medical literature. Am Fam Physician. 2004; 69:548-556. PubMed

- Rycroft-Malone J, Seers K, Titchen A, Harvey G, Kitson A, McCormack B. What counts as evidence in evidence-based practice?. J Adv Nurs. 2004; 47:81-90. DOI | PubMed

- Rycroft-Malone J, Seers K, Chandler J, Hawkes CA, Crichton N, Allen C. The role of evidence, context, and facilitation in an implementation trial: implications for the development of the PARIHS framework. Implement Sci. 2013; 8:28. DOI | PubMed

- Prasad V, Ioannidis JP. Evidence-based de-implementation for contradicted, unproven, and aspiring healthcare practices. Implement Sci. 2014;9(1) 10.1186/1748-5908-9-1.

- McCaughey D, Bruning NS. Rationality versus reality: the challenges of evidence-based decision making for health policy makers. Implement Sci. 2010; 5:39. DOI | PubMed

- Bernet AC, Willens DE, Bauer MS. Effectiveness-implementation hybrid designs: implications for quality improvement science. Implement Sci. 2013; 8(Suppl 1):S2. DOI

- Brownson RC, Colditz GA, Dobbins M, Emmons KM, Kerner JF, Padek M. Concocting that magic elixir: successful grant application writing in dissemination and implementation research. Clin Transl Sci. 2015; 8:710-716. DOI | PubMed

- University of Colorado Implementation Science Program. Ten key ingredients to writing successful d&i research proposals. 2018.

Fonte

Crable EL, Biancarelli D, Walkey AJ, Allen CG, Proctor EK, et al. (2018) Standardizing an approach to the evaluation of implementation science proposals. Implementation Science : IS 1371. https://doi.org/10.1186/s13012-018-0770-5